线性代数的本质

向量究竟是什么?

可以看作ordered list of numbers

向量加法:对应项相加,理解为空间中的移动

向量数乘:scaling,缩放,使用标量scalars和向量相乘完成对向量的缩放,标量和向量的每个分量相乘

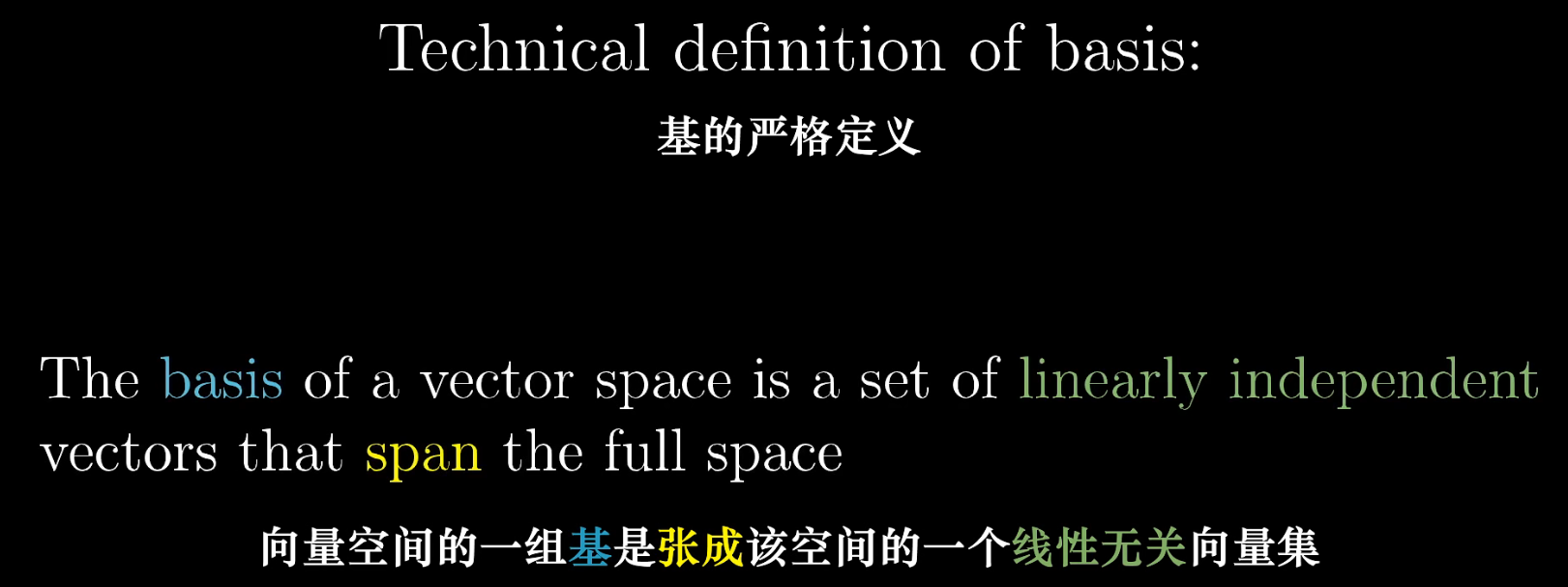

线性组合、张成的空间和基

基向量的线性组合得到的向量集称为span(张成的空间)

多个向量,可以移除其中一个而不减少张成的空间,称这些向量线性相关

另一种表述是,其中一个向量可以表示为其他向量的线性组合,因为这个向量已经落在了其他向量张成的空间中

如果所有向量都给张成的空间添加了新的维度,则线性无关

矩阵与线性变换

线性变换 Linear Transformation

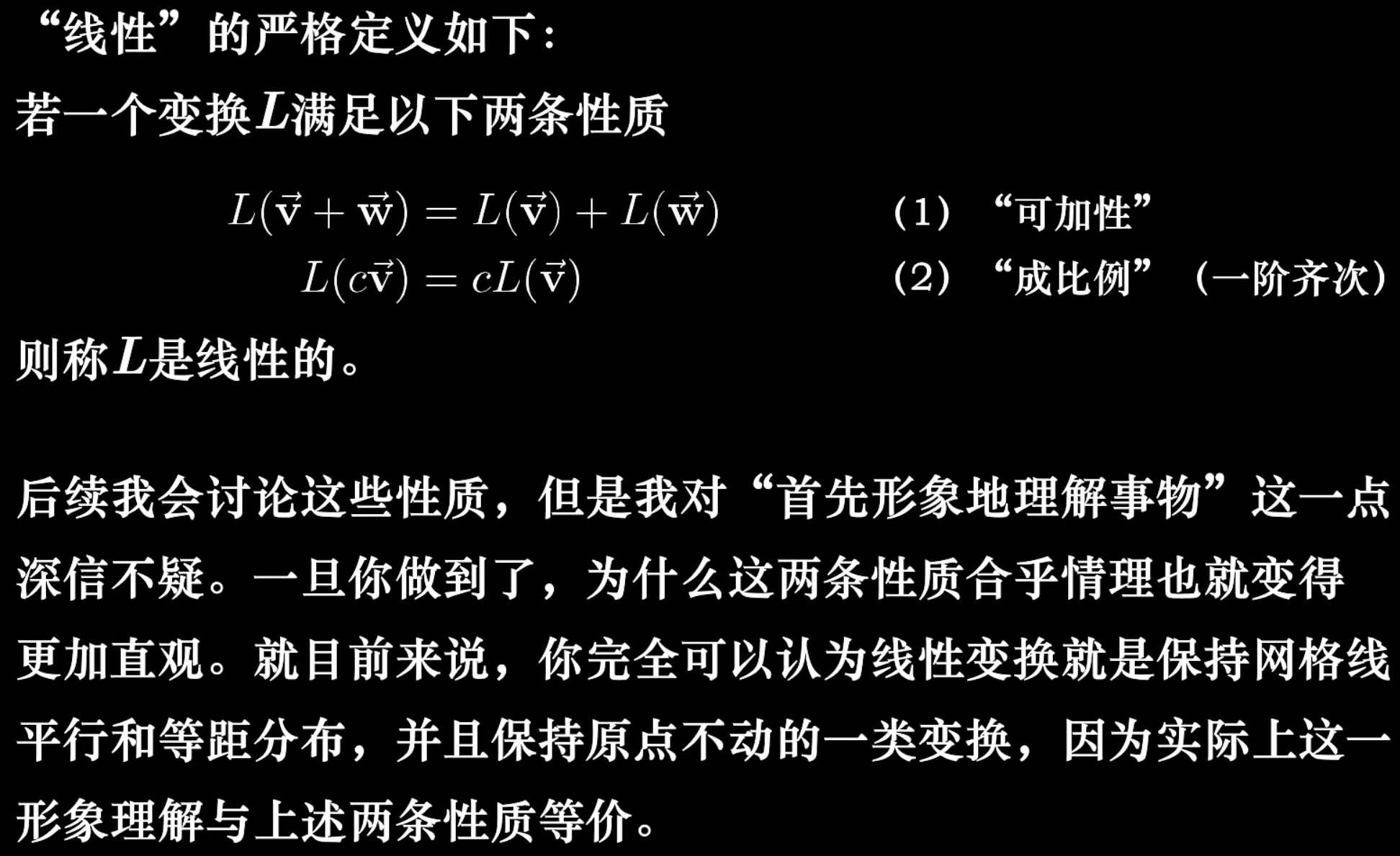

当变换满足以下性质时,称为线性:

- 直线在变换后依旧是直线,且网格线等距分布

- 推论:$\vec{u}=a\vec{x}+b\vec{y}$, $\vec{u}$的线性变换 $tans(\vec{u})=atans(\vec{x})+btrans(\vec{y})$

- 原点保持固定

若原点移动但其他满足,则为仿射变换

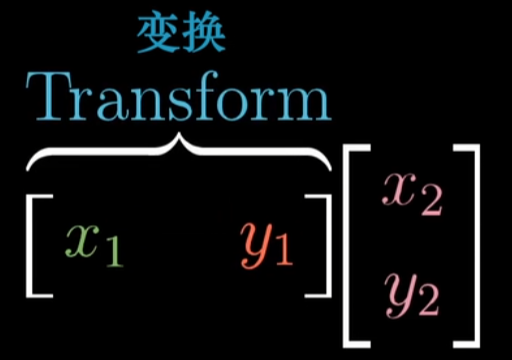

矩阵乘法和线性变换的关系

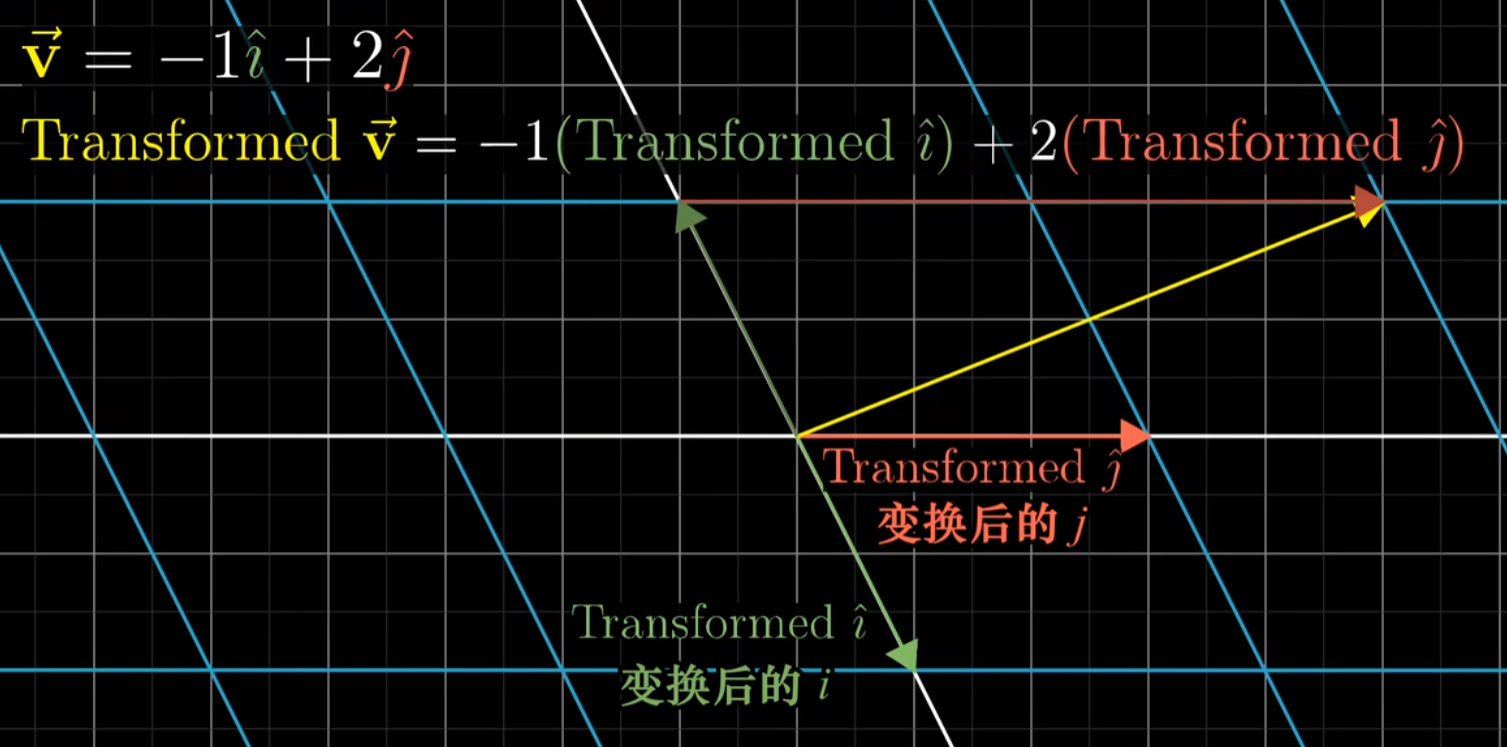

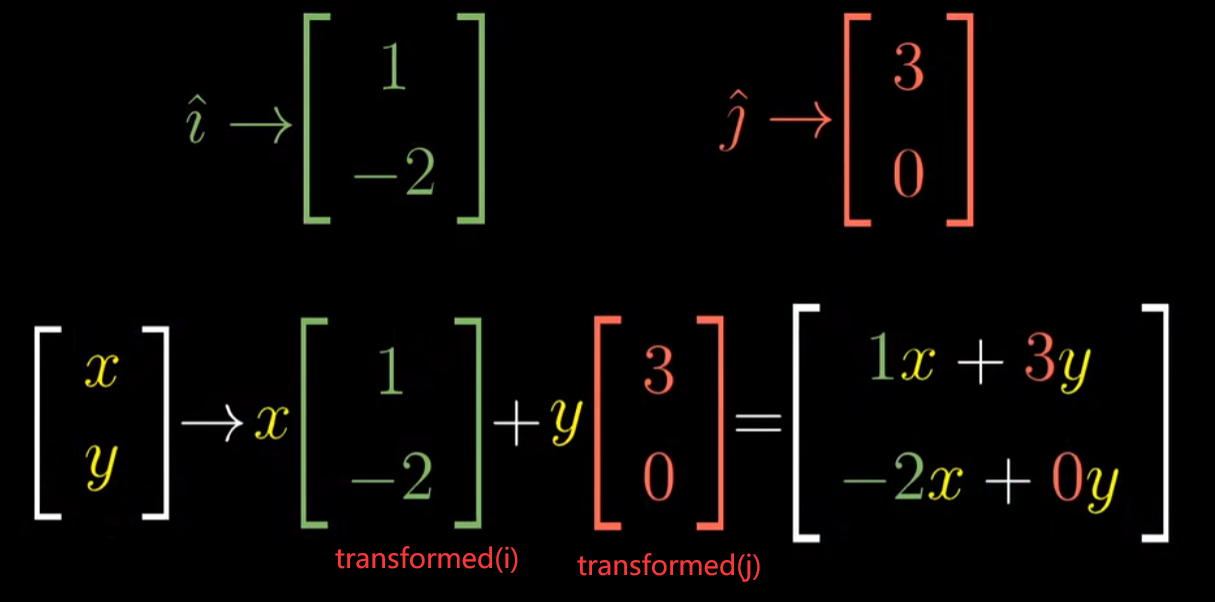

原本的基向量$\vec{i}=\left[ \begin{matrix} 1\\ 0\end{matrix} \right]$, $ \vec{j}=\left[ \begin{matrix} 0\\ 1\end{matrix} \right]$,

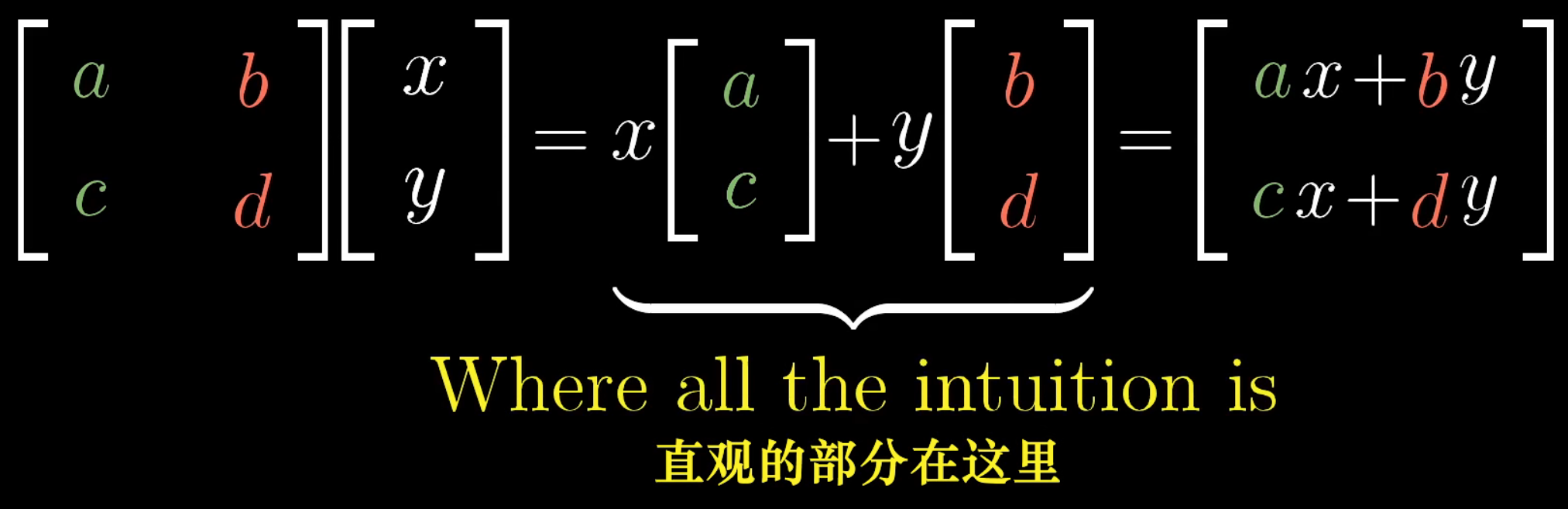

每一列就是一个基向量:矩阵可以理解为第一列是变换后的第一个基向量 $\vec{i}$,第二列则是变换后的第二个基向量$\vec{j}$,将这一矩阵表示的线性变换作用于任意一个向量,最终的结果是基向量的线性加权求和(线性组合,含义是先缩放再做向量加法),权值就是$x$和$y$

列线性相关:一个列向量是另一个的倍数(这说明两个变换后的基向量是共线的,这就导致了会将2维空间压缩到直线上)

把矩阵的列看作变换后的基向量,把矩阵向量乘法看作它们的线性组合, 如果列线性相关,则会压缩维度,如列相关的2x2矩阵代表的线性变换会将一个二维空间挤压到一条直线上,也就是这两个线性相关的列向量张成的一维空间

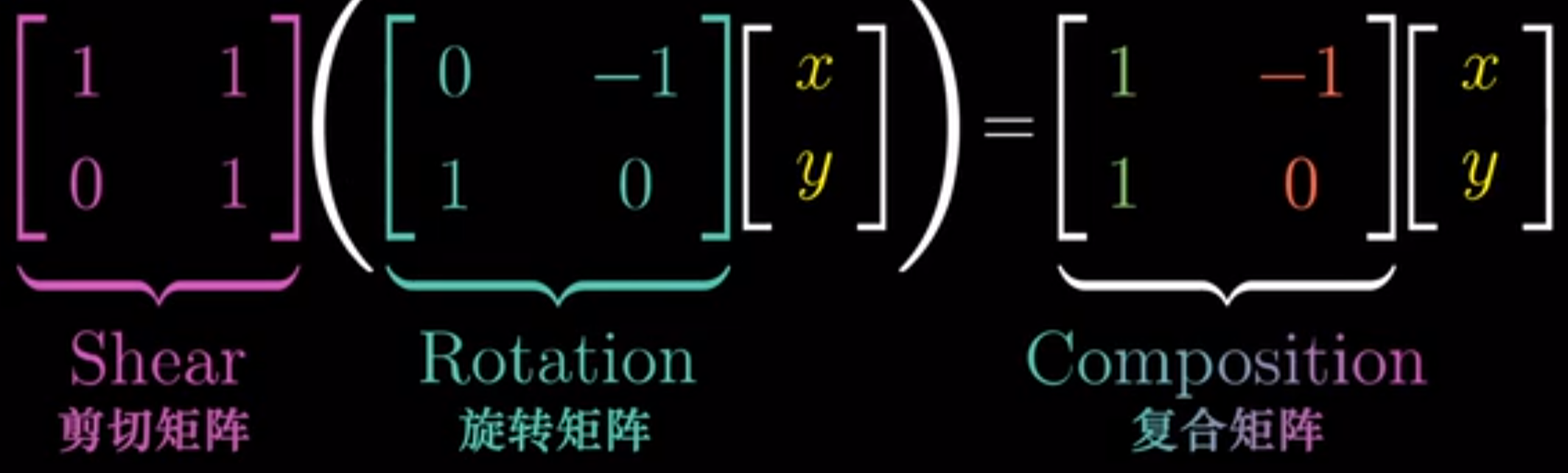

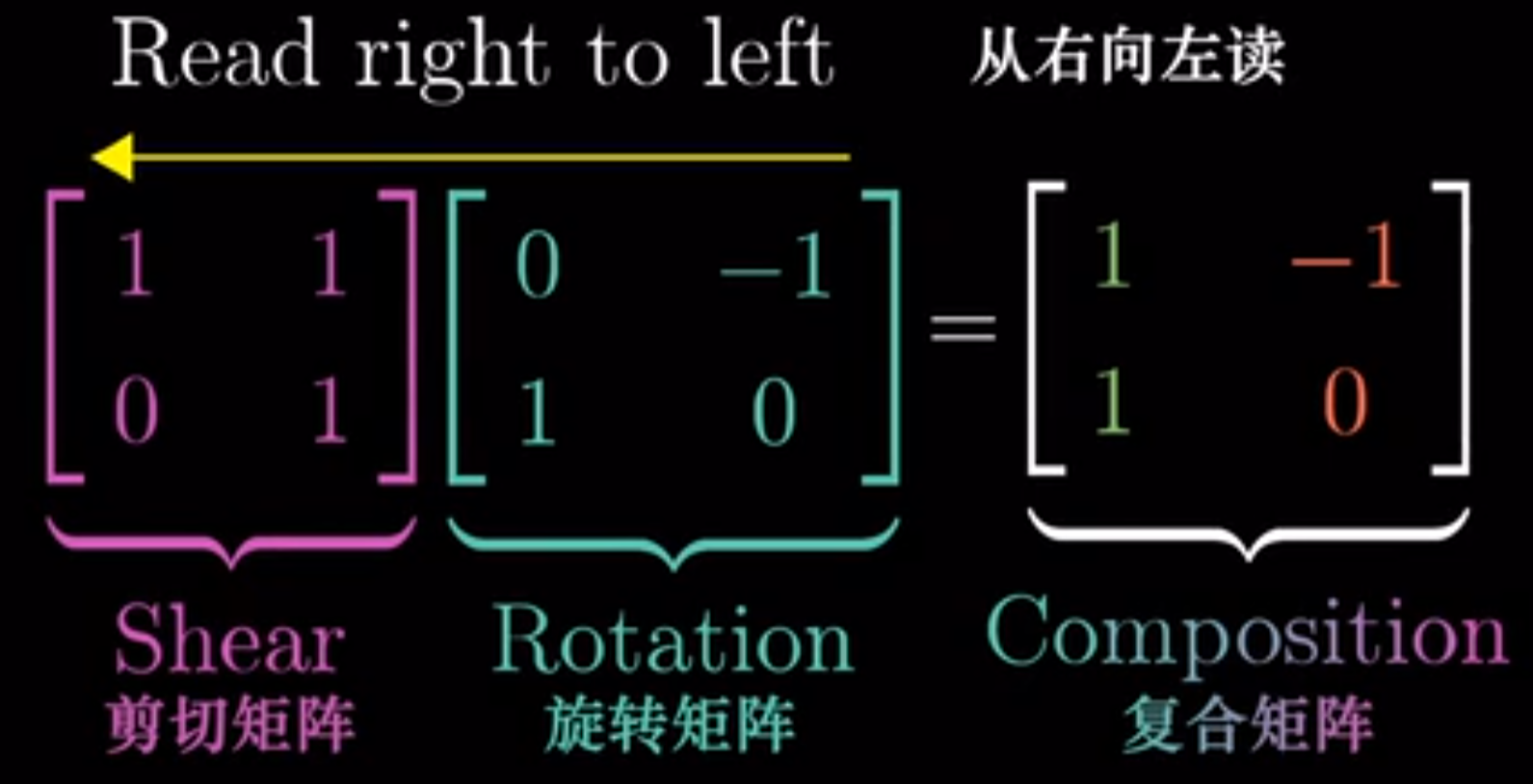

先旋转再剪切

从右向左读,先旋转后剪切

矩阵的乘积就是多个矩阵对应的线性变换相继作用,矩阵乘法不满足交换律,满足结合律

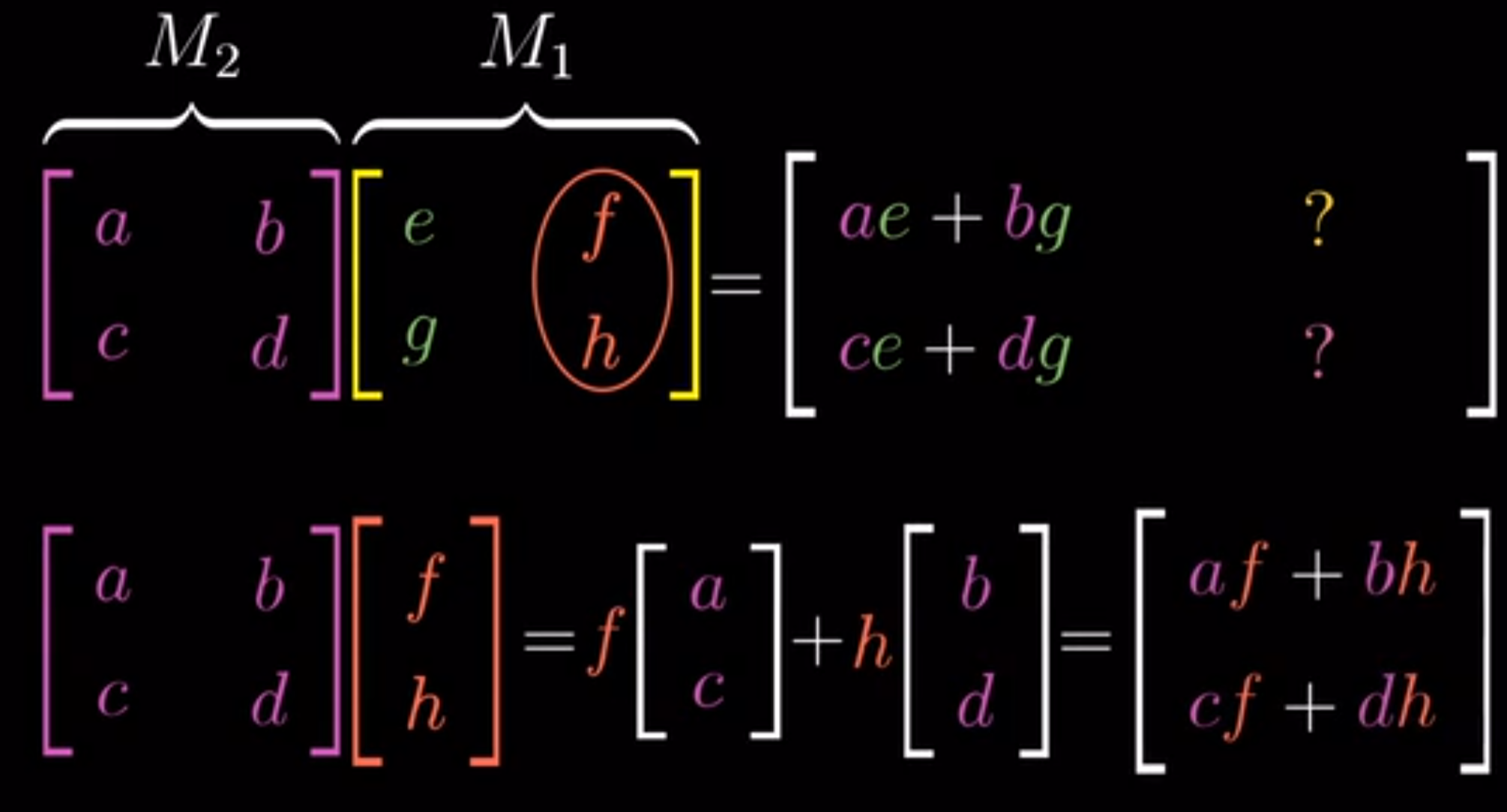

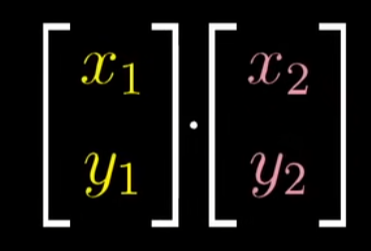

两个矩阵相乘,将第一个作用的矩阵即M1看作变换后的基向量的组合(也就是基向量第一次到达的地方),然后将第一次变换后得到的基向量$\left[\begin{array}{l}

e \\

g

\end{array}\right]$再使用M2进行变换,也就是使用上一节中的矩阵和向量的乘法,得到最终的基向量

把M1中的每一列看作变换后的基向量,然后使用M2对每一个基向量做矩阵和向量的乘法,得到最终的基向量,也就是复合矩阵的对应列,比如矩阵和第一个基向量$\left[\begin{array}{l}

e \\

g

\end{array}\right]$相乘,得到的结果就是复合矩阵的第一个基向量(第一列)

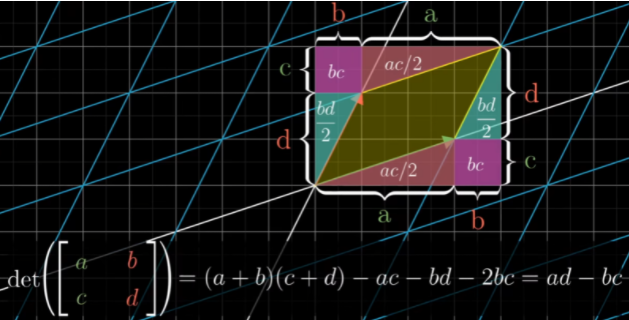

行列式

一个变换的行列式为3,意味着这一变换会将一个区域的面积(体积)增加为原来的3倍

行列式的正负决定了定向,相当于翻转,行列式绝对值代表了区域面积的缩放比例

行列式为零,代表变换后的体积(3dim到2dim)、面积(2dim到1dim)为0, 也代表了这一矩阵是列线性相关的

- 为什么是列线性相关的:列线性相关说明有两个基向量是共线的,这就导致了空间的压缩

关于行列式的正负号,对于三维而言,可以使用右手定则

如果在变换后还满足右手定则,则为正,如果是满足左手,则为负

复合矩阵的行列式等于两个矩阵的行列式的乘积

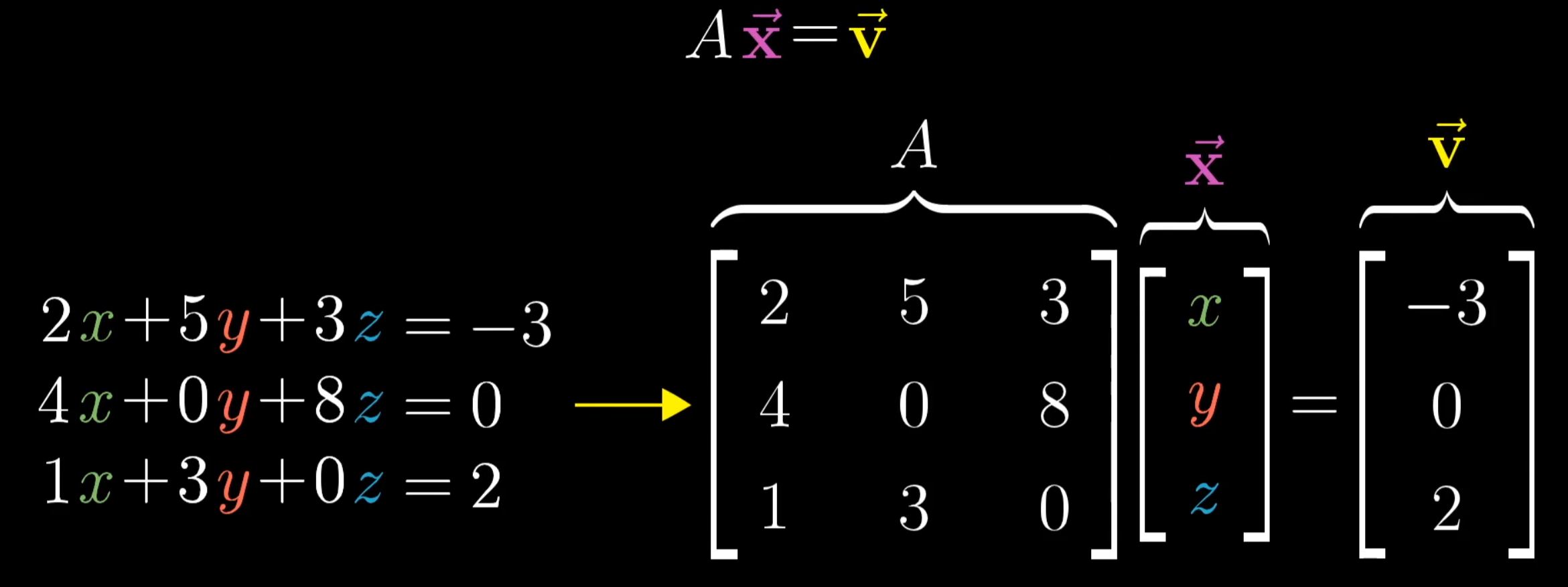

逆矩阵、列空间与零空间、秩

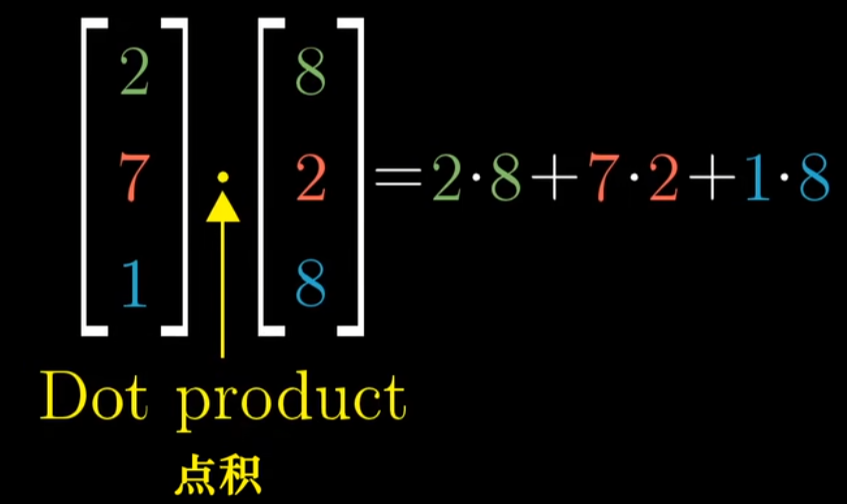

整理一个线性方程组,所有未知量放在等号左边,常数项放在等号右边

常数系数constant coefficients,未知变量variables,常数向量

$A\vec{x}=\vec{v}$可以理解成,我们需要寻找一个向量$\vec{x}$,其经过$A$的线性变换后,与向量$\vec{v}$重合

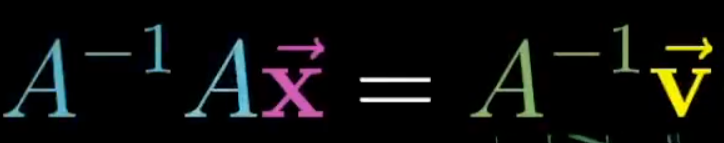

- 对于线性变换A和向量$\vec{v}$,寻找一个向量 $ \vec{x}$在变换后和向量$\vec{v}$重合,只要变换A不将空间压缩到一个更低的维度上,也就是行列式不为0,就一定存在逆变换$A^{-1}$, 使得使用变换A再使用了逆变换 $ A^{-1}$的结果与使用恒等变换的结果一致

- 求解方程$A\vec{x}=\vec{v}$( $det(A)\neq0$)

当行列式为0时( $det(A)=0$),矩阵A对应的变换将空间压缩到更低的维度上,此时就没有逆变换,因为没办法将一条直线“解压缩”到一个平面,或者将一个平面“解压缩”到3维空间,因为函数只能一个输入对应一个输出

- 当逆变换不存在时,方程仍可能有解,比如A将空间压缩成直线,但$\vec{v}$恰好落在这条直线上。

- 如果$\vec{v}$没有落在这条直线上,则无解

- 可以利用最小二乘求近似解,也就是在A的空间中寻找$\vec{v}$的投影,$A\vec{x}=Project(\vec{v})$

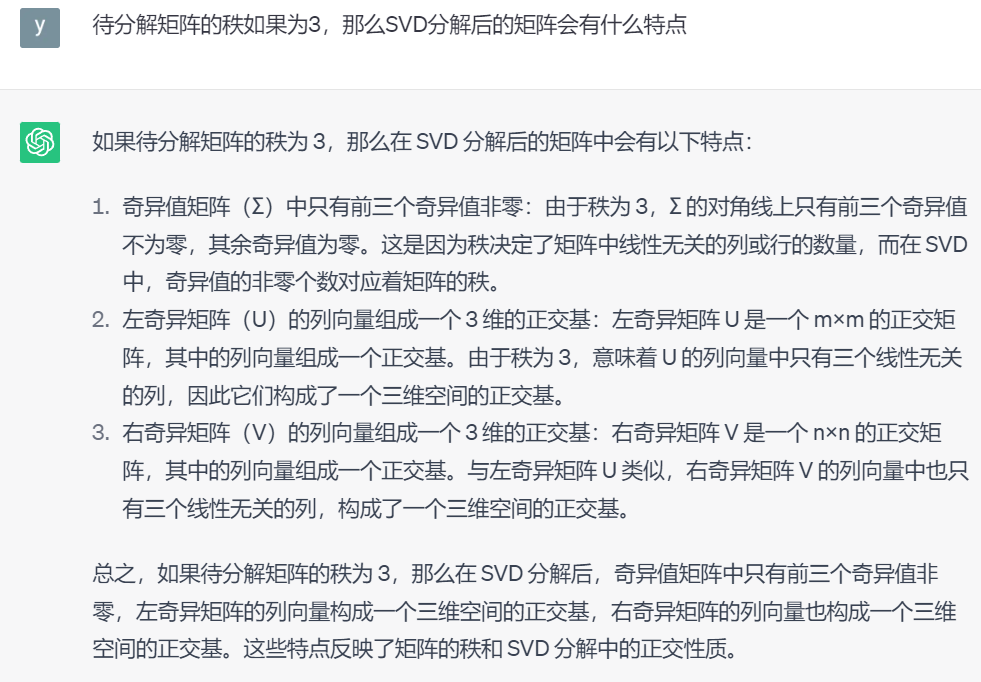

秩代表了变换后空间的维数,也就是变换后的基向量能张成的最大空间

- 变换后的结果是一条直线,也就是一维的,称这个变换的秩rank为1

- 变换后的向量落在某个2维平面上,则称变换的秩为2

- 列空间就是矩阵的列(变换后的基向量)张成的空间,也是变换后的空间,秩就是列空间的维数,秩和列数相等时(秩达到最大),称为满秩,零向量一定在列空间中,因为线性变换保持原点固定不变

- 满秩时,原向量和变换后的向量都有一一对应的关系,比如变换后能落在原点的向量只有零向量本身

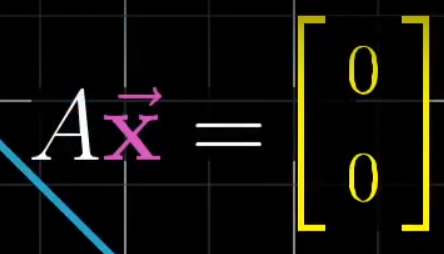

变换后落在原点的原空间中向量的集合称为零空间null space, 也称为矩阵的核kernel

变换后一些向量落在零向量上,“零空间”正是这些向量所构成的空间,若矩阵满秩,则只有原空间中的零向量能落在变换后的零向量上,从方程$A\vec{x}=\vec{v}$中体现为, $ A$矩阵满秩,也就是A中各列向量线性无关,$\vec{x}$存在为一解。

零空间也是方程的解,也就是齐次解

- $A\vec{x}$,当A是3x2的矩阵时,实际上是把输入 $ \vec{x}$从二维的输入空间映射到三维空间,矩阵有两列代表输入空间有两个基向量(矩阵乘法中第一个矩阵的列数和第二个矩阵的行数一致,x是个2行1列的向量),有三行表示每一个基向量在变换后都用三个独立的坐标来表述

点积和对偶性

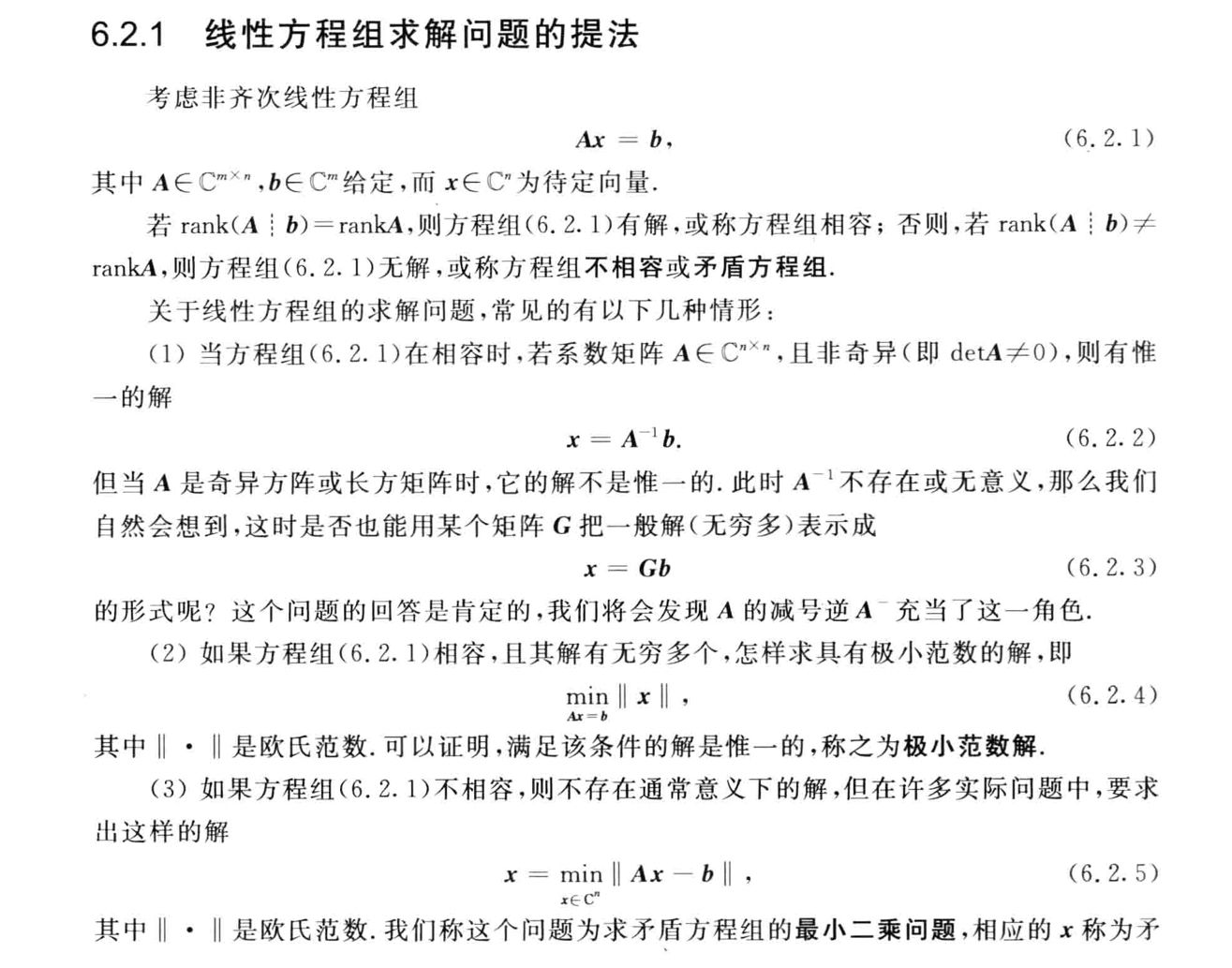

对于两个维度相同的向量,点积Dot product就是对应位置相乘然后再相加

点积的几何解释:求两个向量的点积,在几何上就是将其中一个向量投影到另一个向量上,然后将投影得到的长度和另一向量长度相乘,符号就是看投影之后的向量和另一向量是否同向

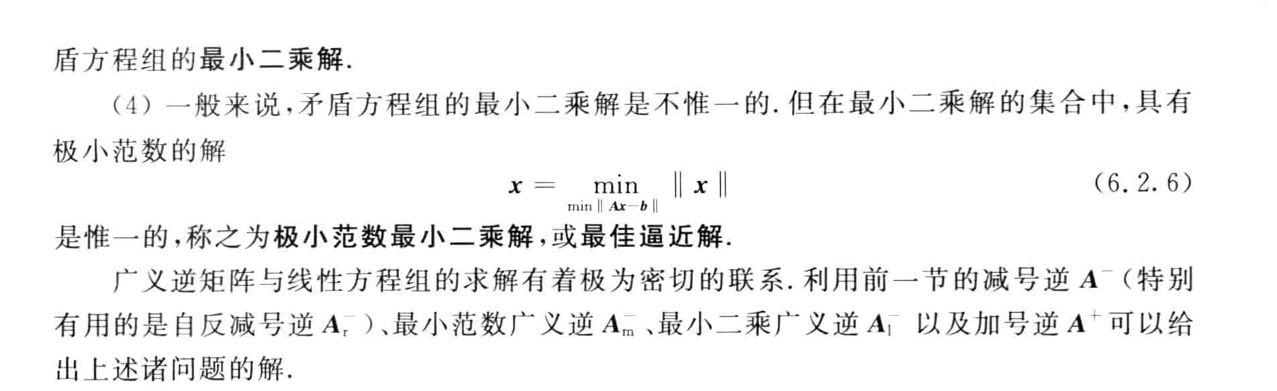

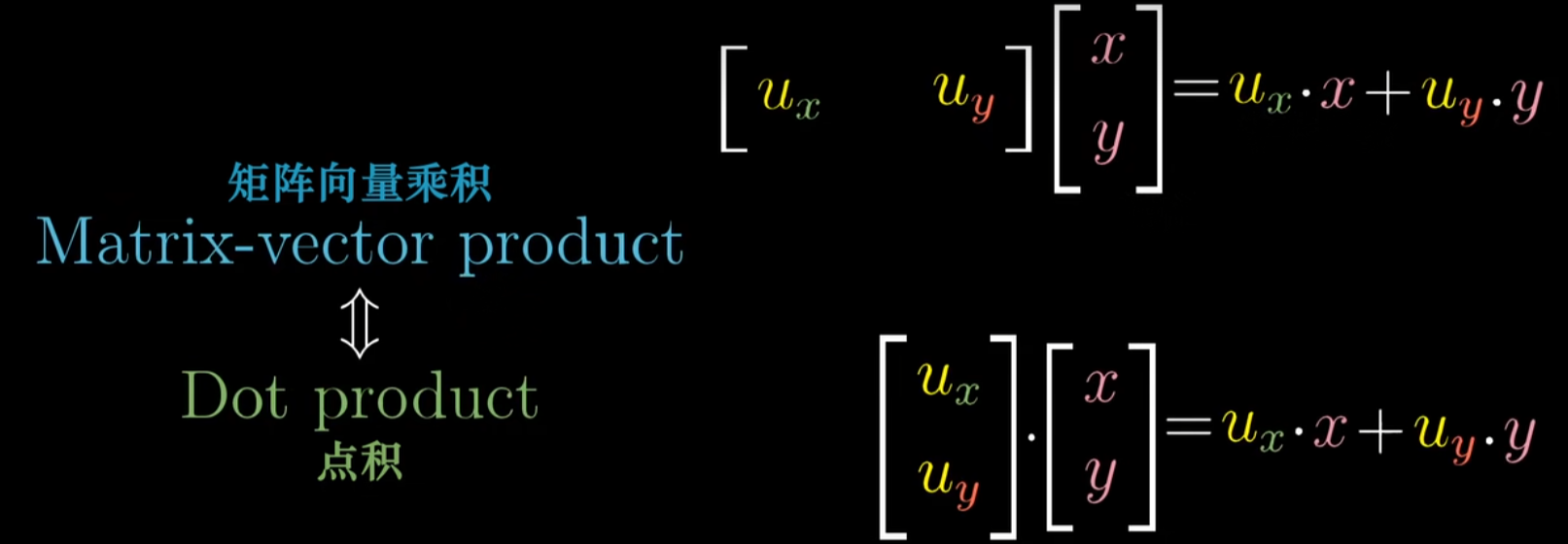

从$1\times2$的投影矩阵和向量乘积理解点积:

- 描述投影变换的$1\times 2$矩阵的两列,就分别是$\vec{u}$(一个单位向量)的两个坐标,而空间中任意向量经过投影变换的结果,也就是投影矩阵和这个向量相乘,和这个向量与$\vec{u}$的点积在计算上完全相同

- 单位向量的点积可以解读为将向量投影到单位向量所在的直线上所得到的投影长度

- 在任何时候看到一个线性变换,其输出空间是一维数轴(比如一个二维到一维的线性变换$[4\ 1]$),空间中会存在唯一的向量$\vec{v}$与之相关,因此应用这个线性变换和与向量$\vec{v}$做点积是一样的

- 将两个向量进行点乘,就是将其中一个向量转换为线性变换

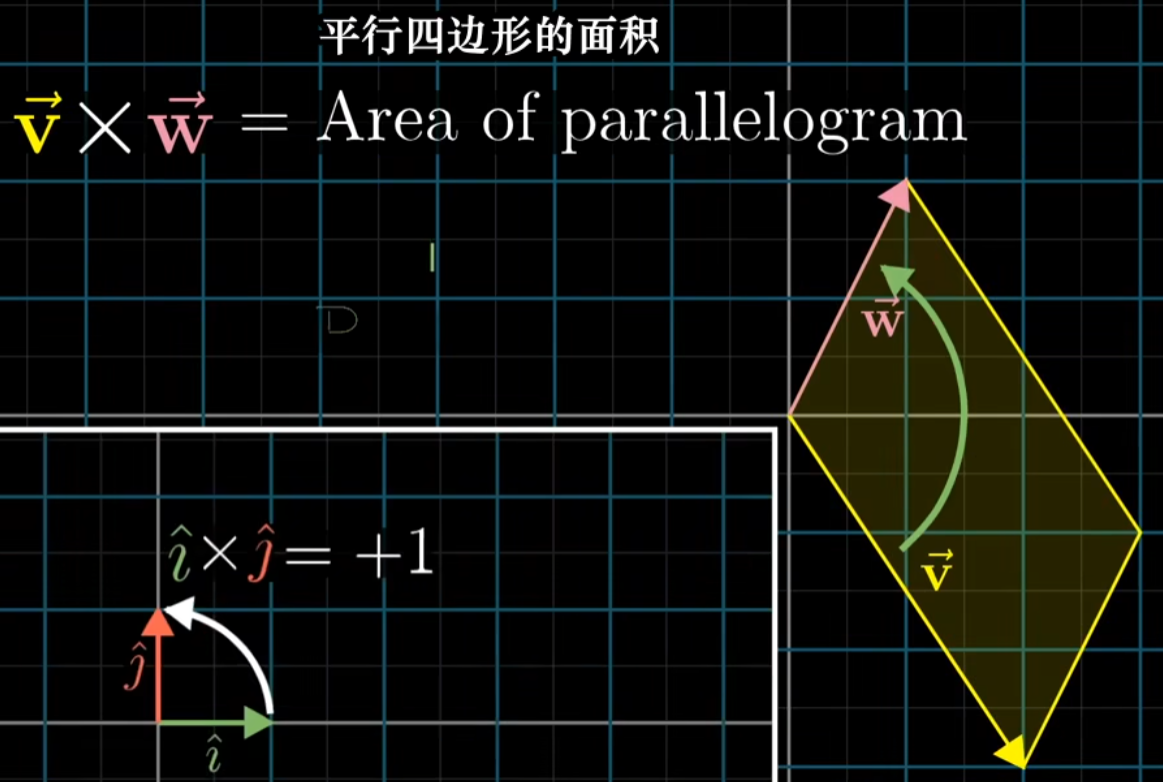

叉积的标准介绍

叉积是两个向量构成的平行四边形的面积

叉积是有顺序的,对于基向量$\vec{i}$和$\vec{j}$,$\vec{i}$在$\vec{j}$的右边,所以为正,反之为负

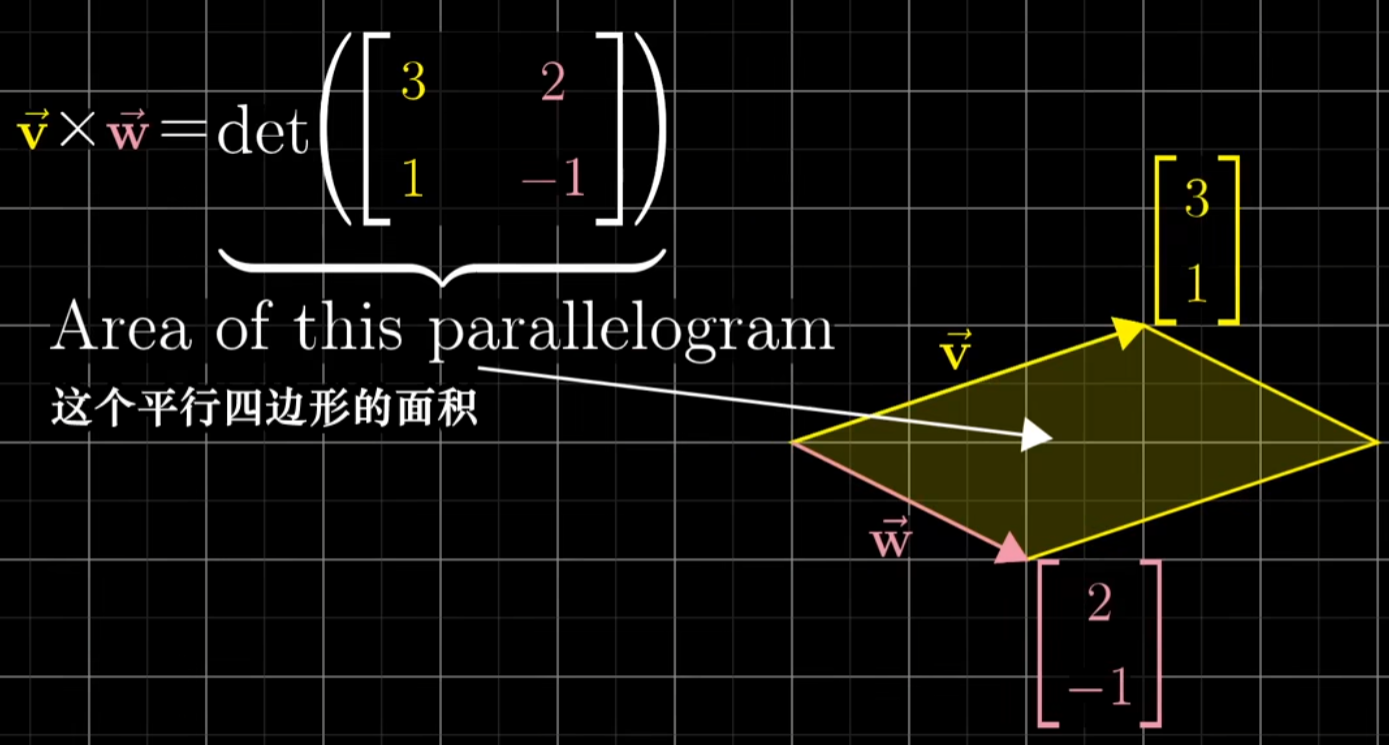

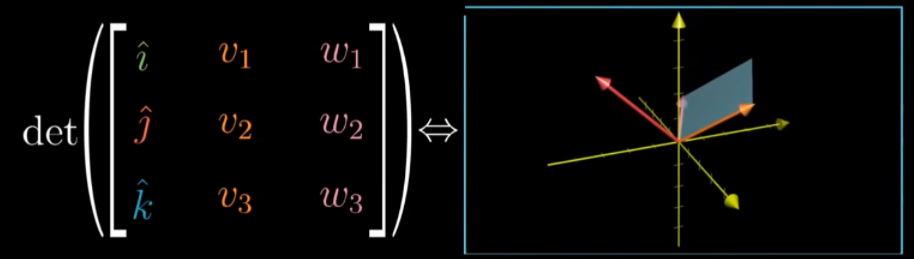

叉积的计算可以利用行列式

将两个向量作为矩阵的列向量,然后计算组成矩阵的行列式

以下这个判定符号为负,因为v在w的左侧

- 两个向量更接近垂直时,平行四边形面积最大

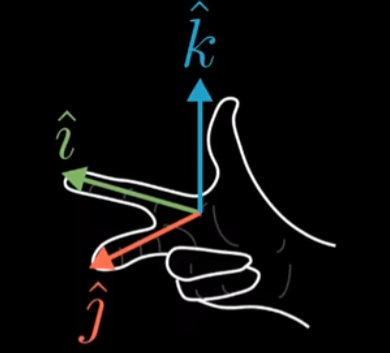

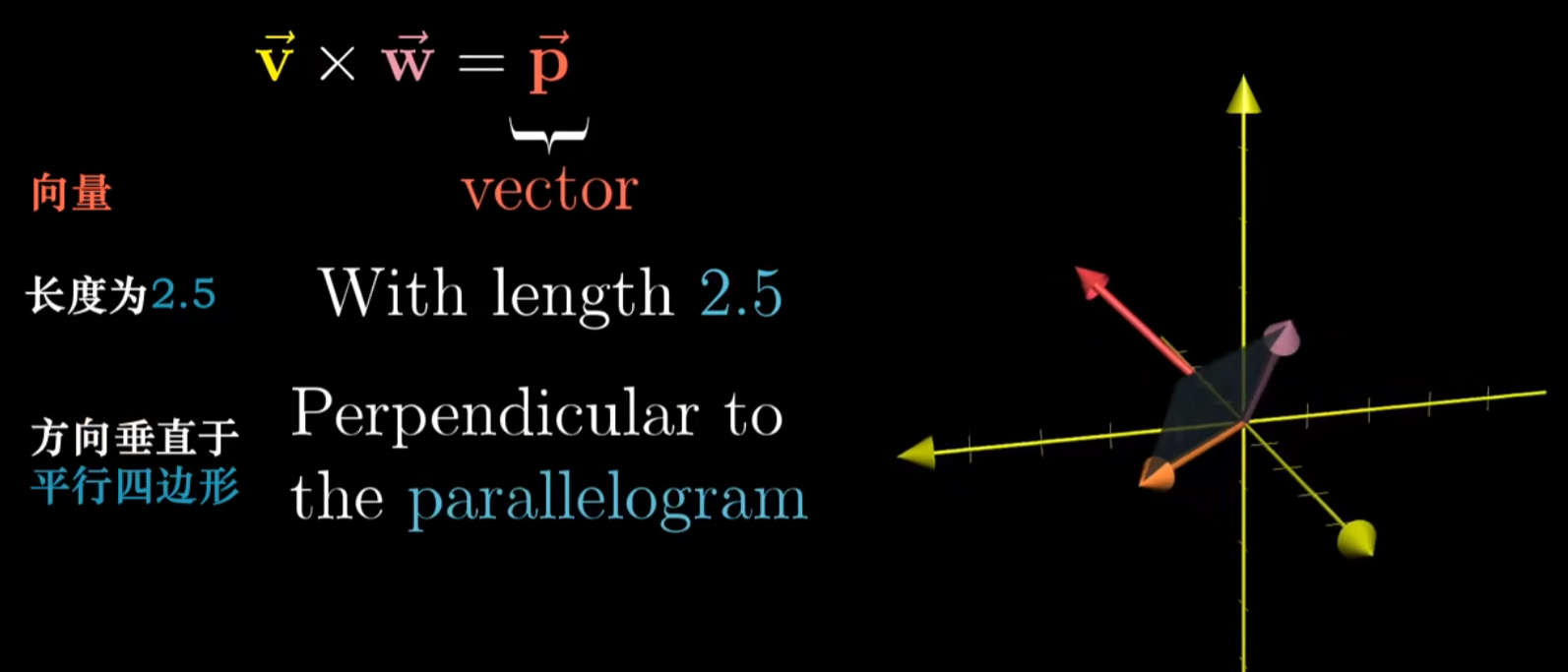

真正的叉积是通过两个三维向量生成一个新的三维向量

- 叉积的结果不是一个数,而是一个向量

- 叉积得到的向量的长度就是平行四边形的面积

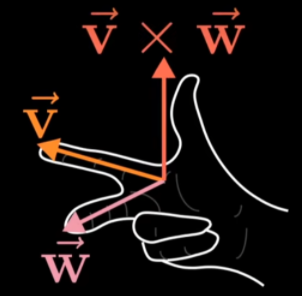

- 方向则垂直于平行四边形,然后用右手定则确定,食指指向v,中指指向w,拇指就是叉积结果向量的方向

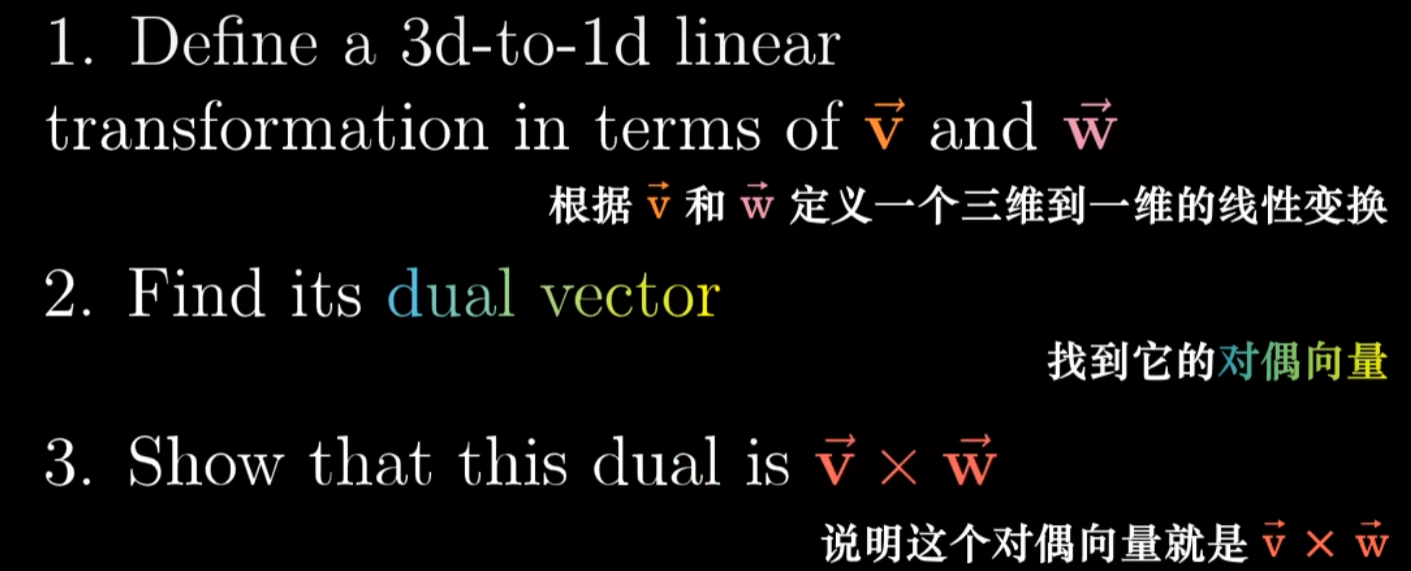

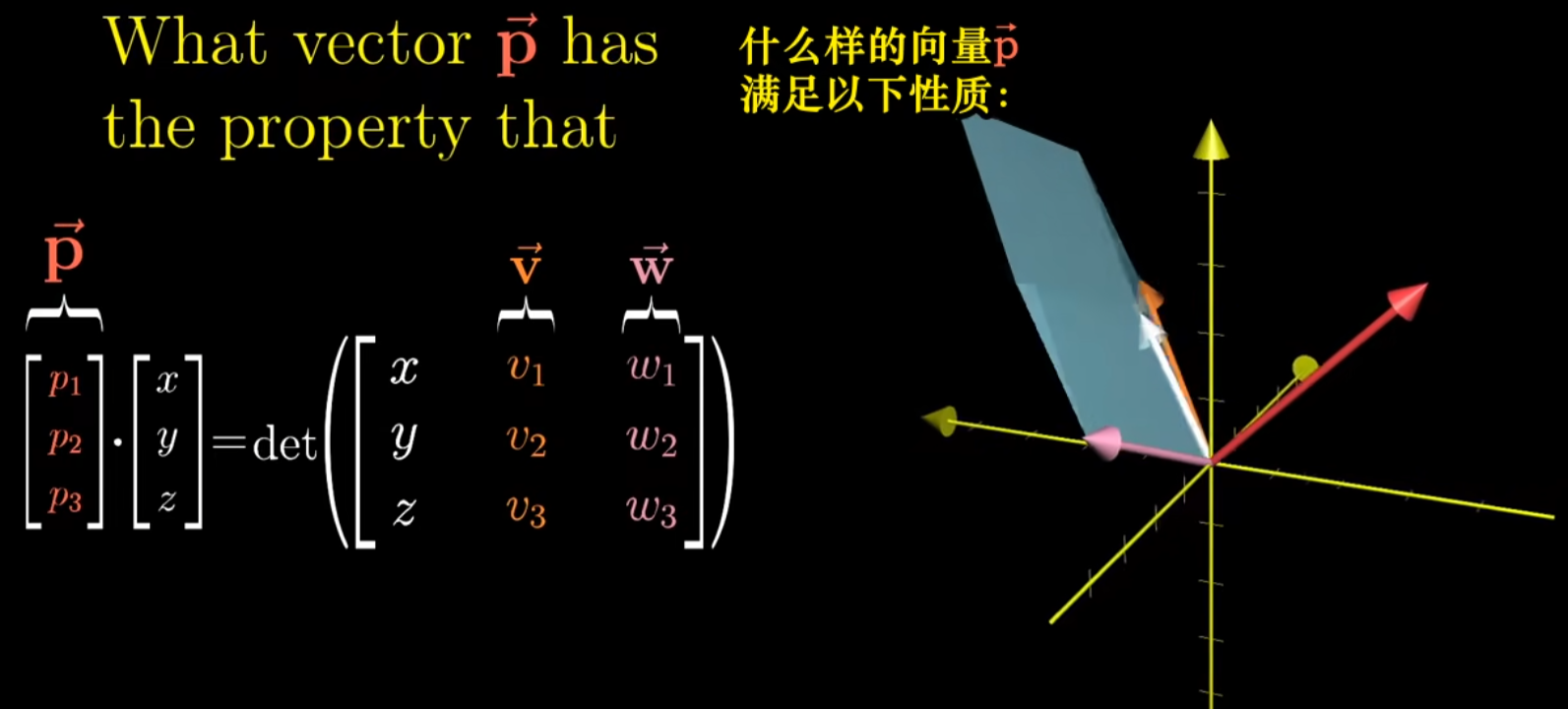

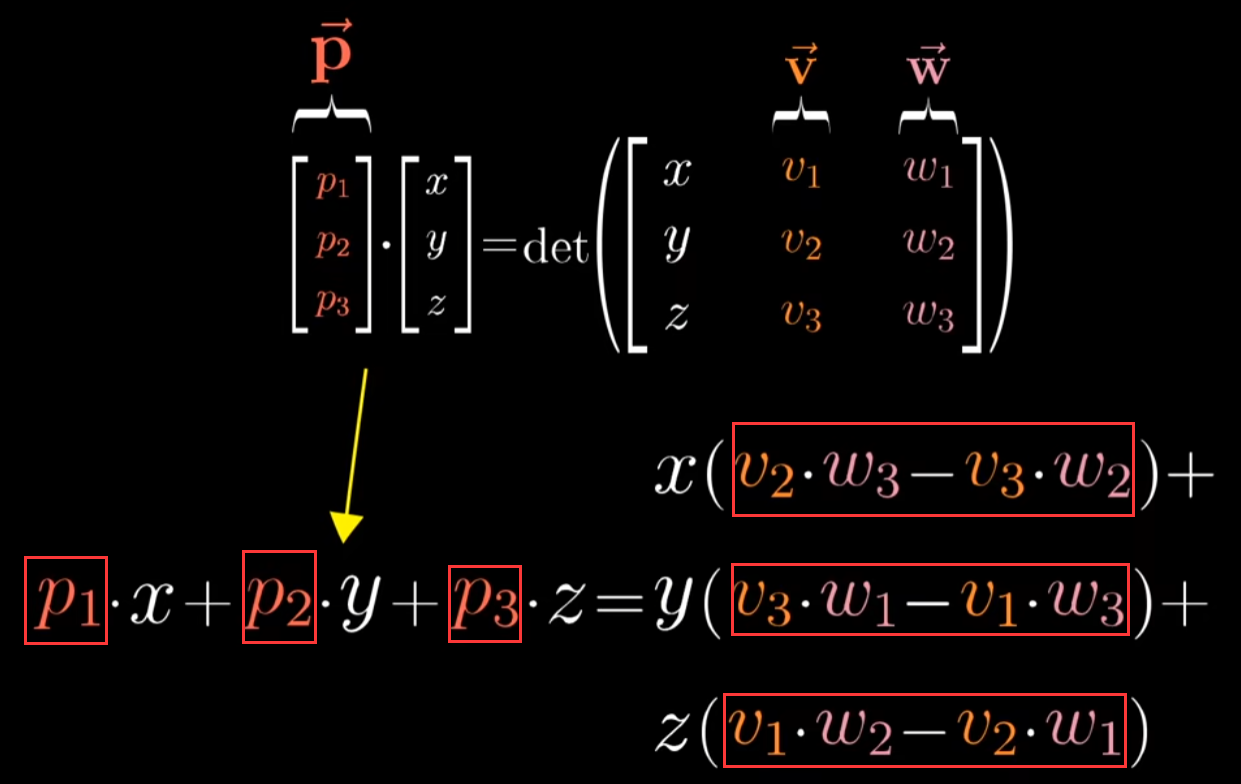

以线性变换的眼光看叉积

当向量$\vec{p}$和某个向量$(x,y,z)$点乘时,所得的结果等于一个$3\times3$矩阵的行列式,这个矩阵的第一列为xyz,其余两列为向量v和向量w的坐标,什么样的向量p可以满足这一性质?

基变换

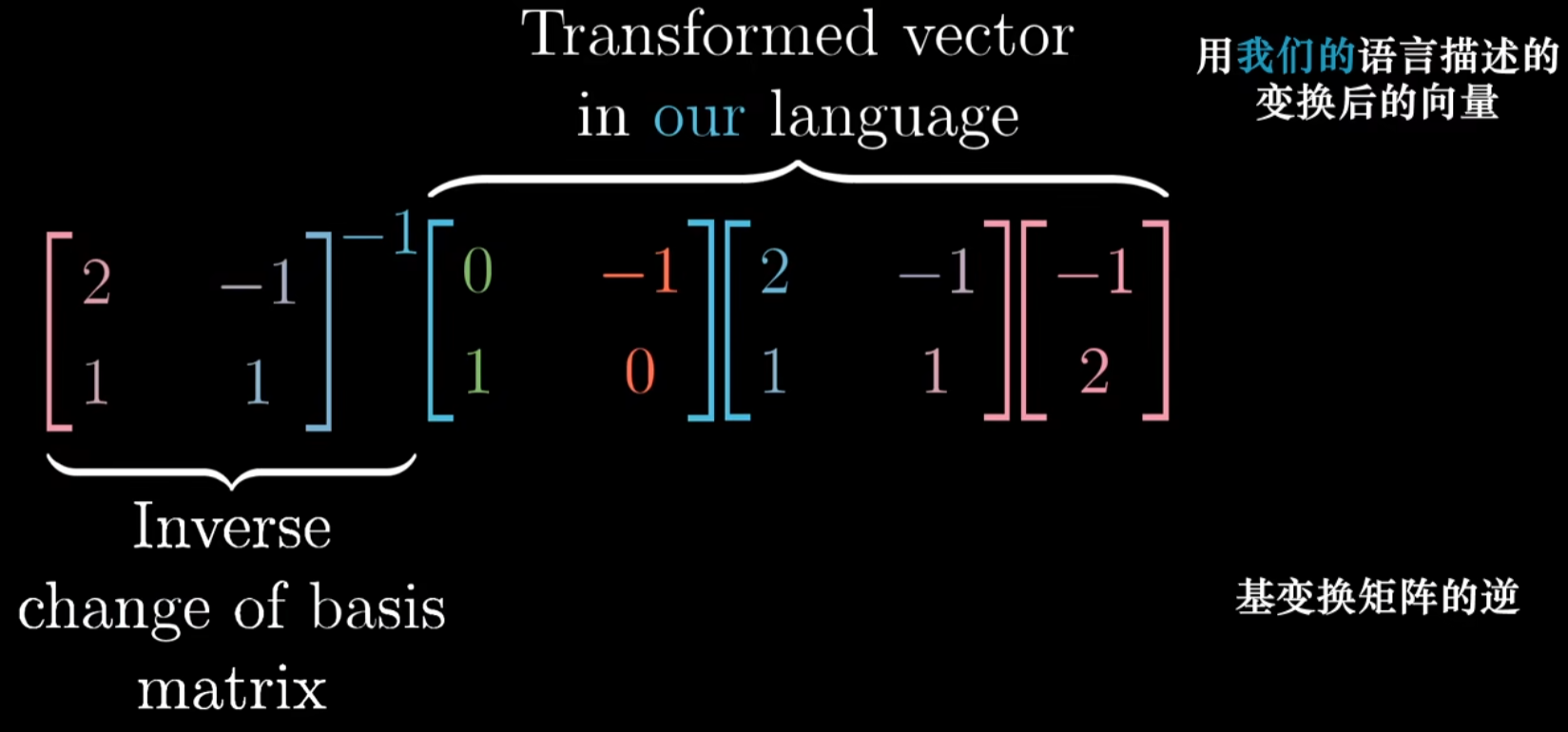

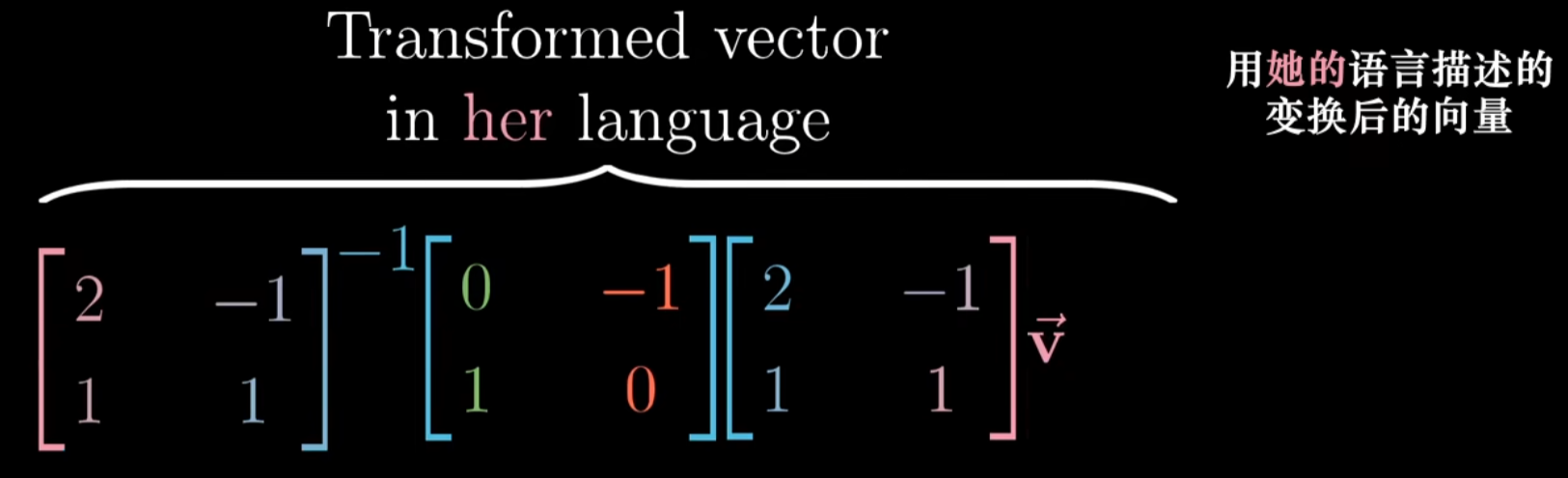

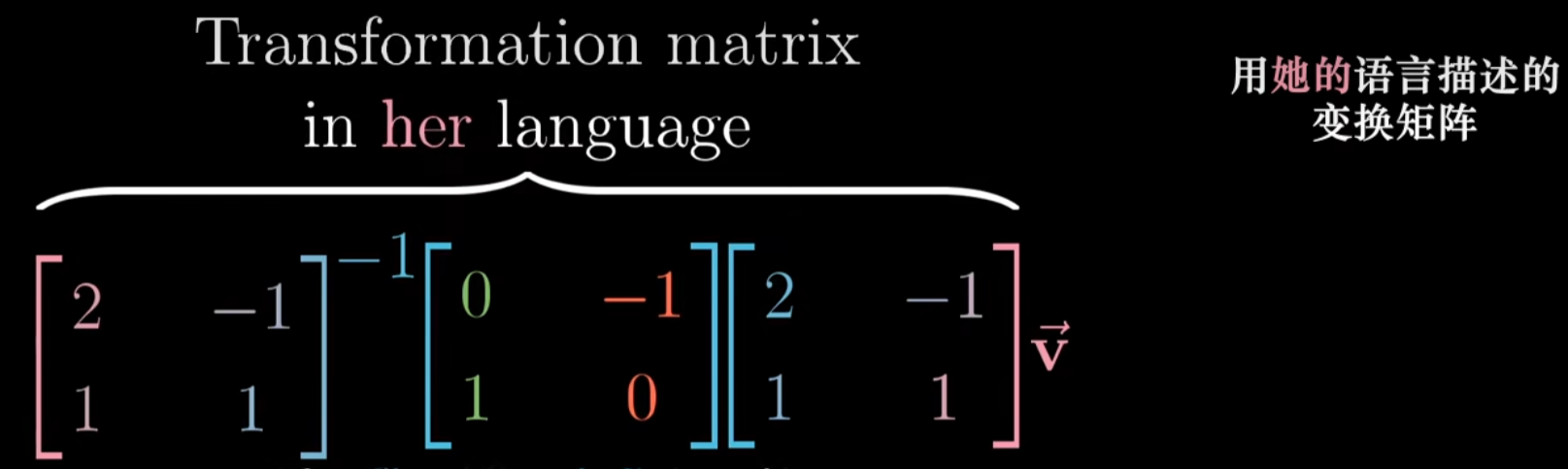

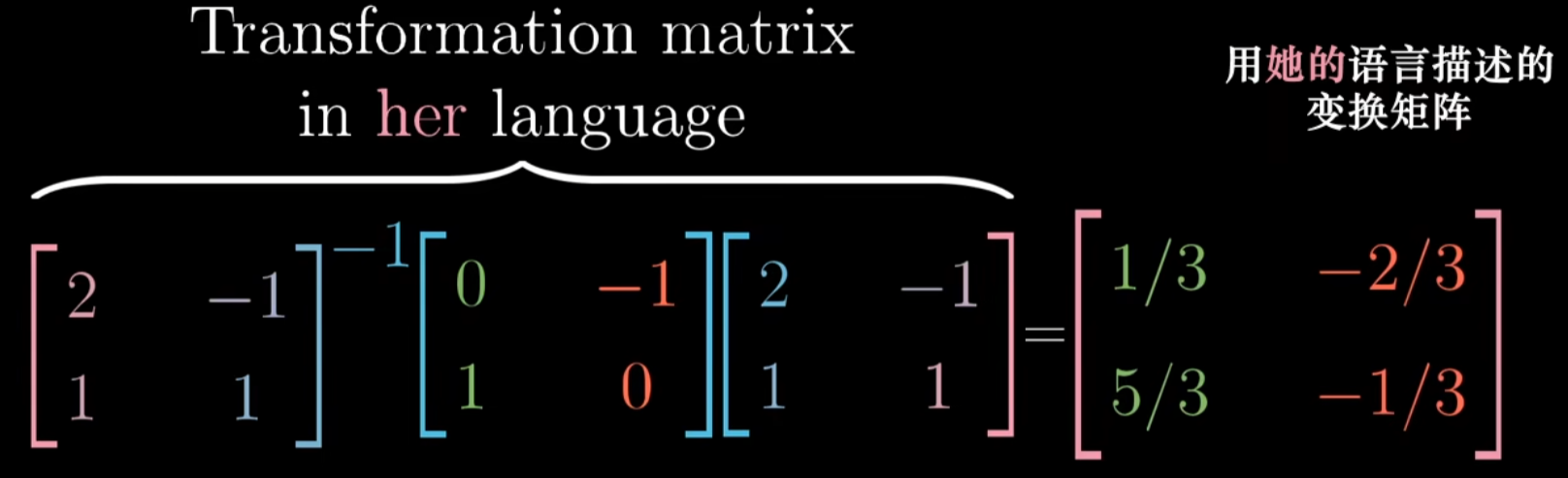

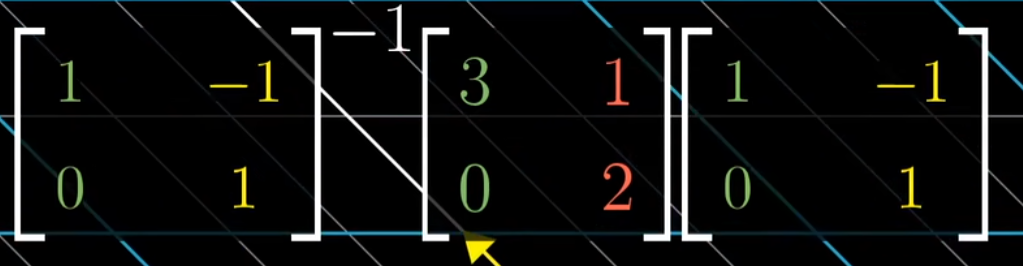

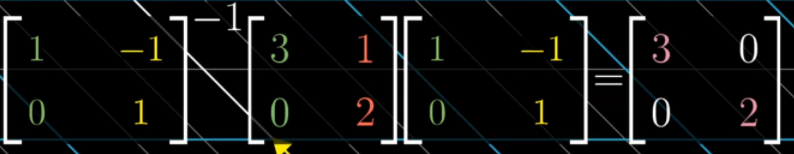

$A^{-1}MA$暗示着一种数学上的转移作用,矩阵$M$代表一种当前基向量视角下的变换,而外侧两个矩阵代表着转移作用,也就是视角上的转换,矩阵乘积仍然代表着同一个变换,只不过是从其他基向量视角的角度来看的

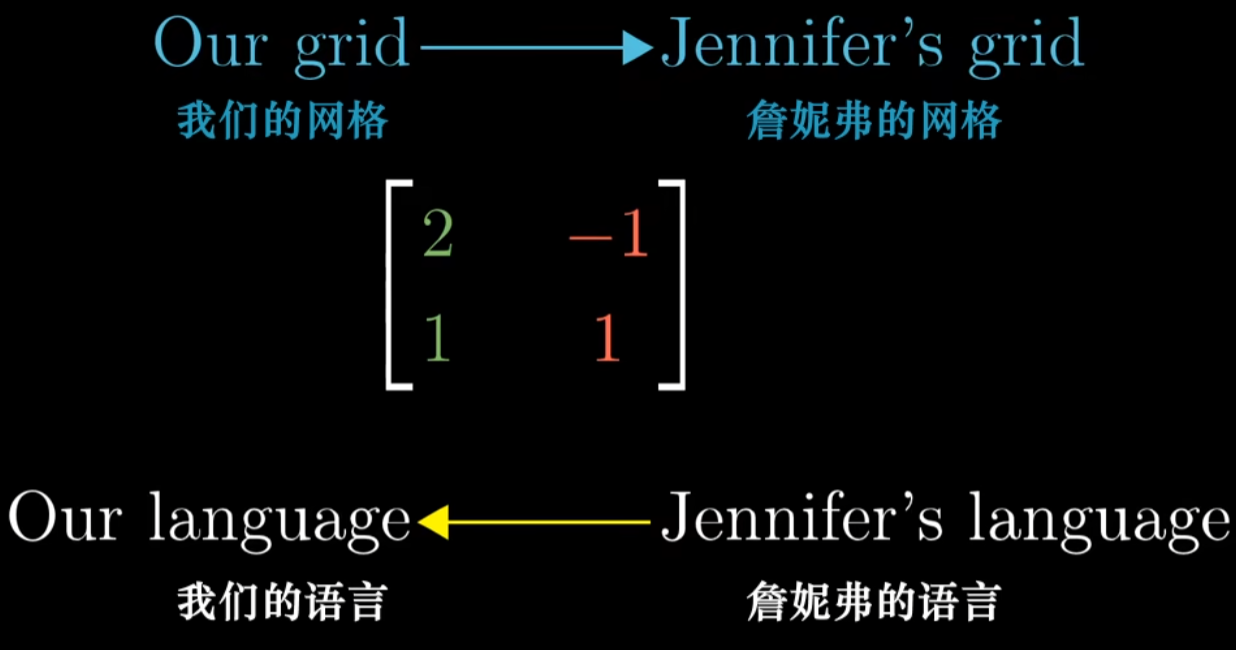

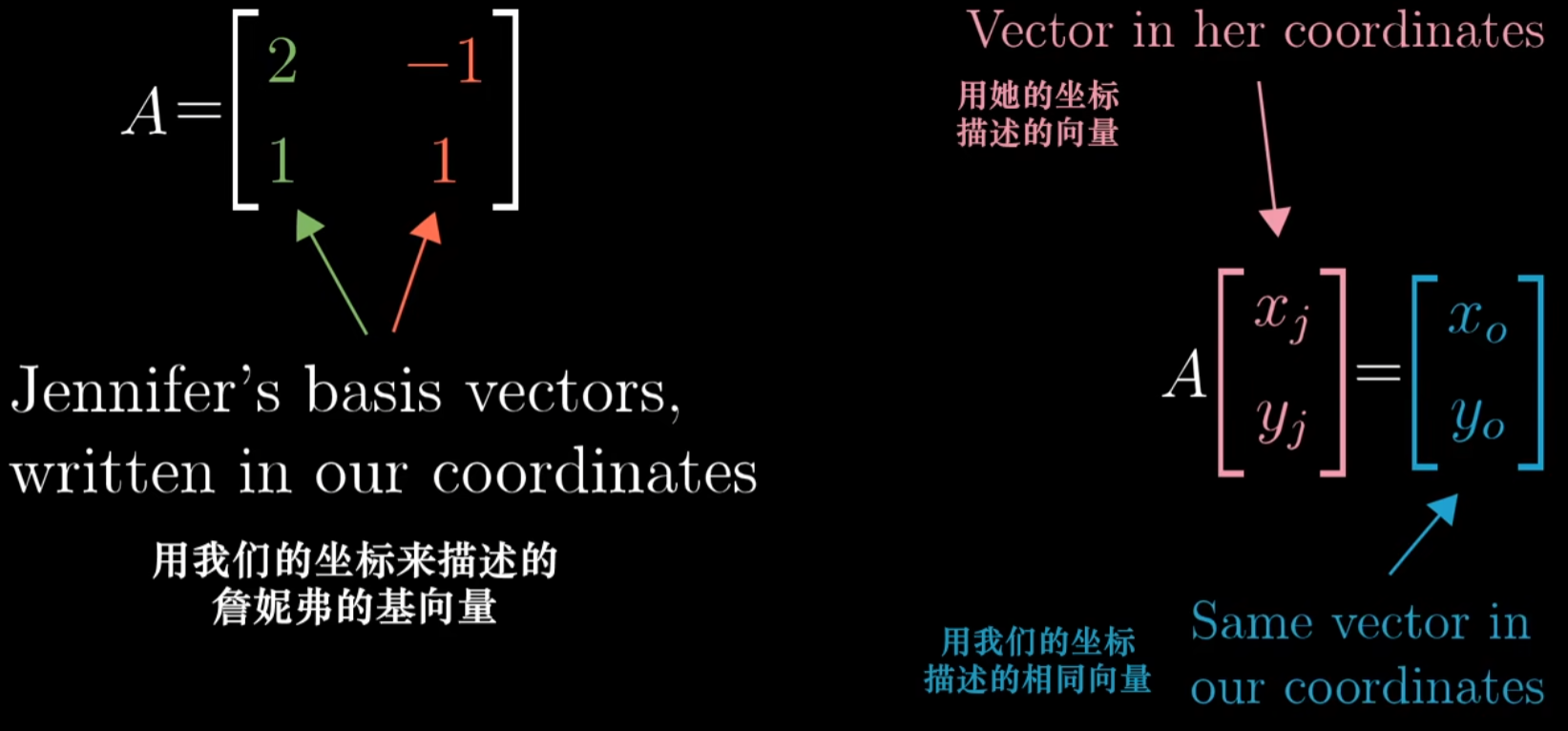

以下詹妮弗和我们分别代表了两个坐标系

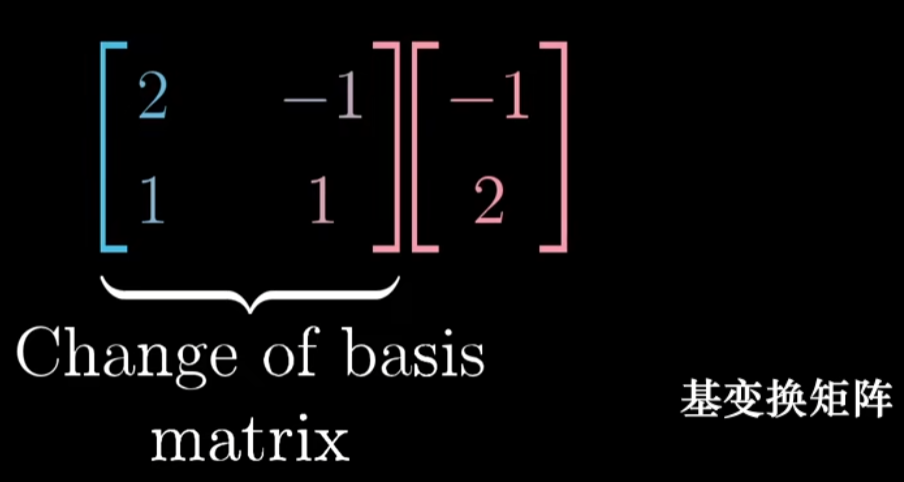

基变换矩阵:基变换矩阵的列为詹妮弗的基向量,这个矩阵可以看作一个线性变换,它将我们的基向量$\vec{i}$和$\vec{j}$,也就是我们眼中的(1,0)和(0,1)变换为詹妮弗的基向量,也就是詹妮弗眼中的(1,0)和(0,1)

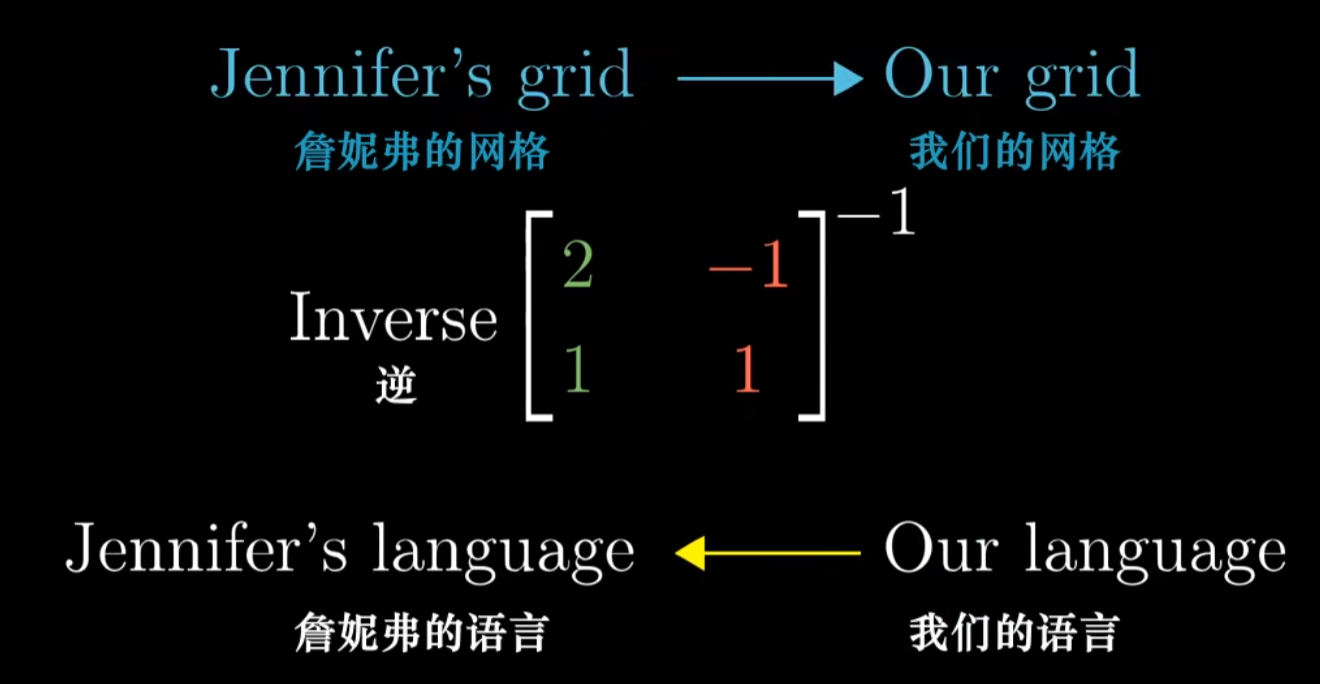

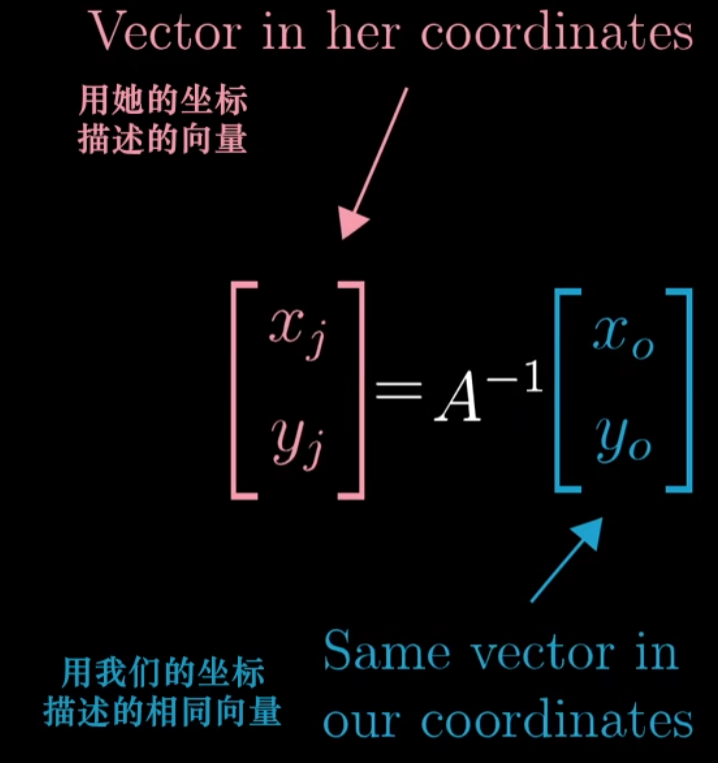

基变换矩阵的逆:

A矩阵的列代表詹妮弗的基向量,但是是用我们的坐标来描述的

对于一个用詹妮弗的语言描述的向量,首先利用基变换矩阵转化为用我们的语言描述,这个矩阵代表的是用我们的语言描述的詹妮弗的基向量

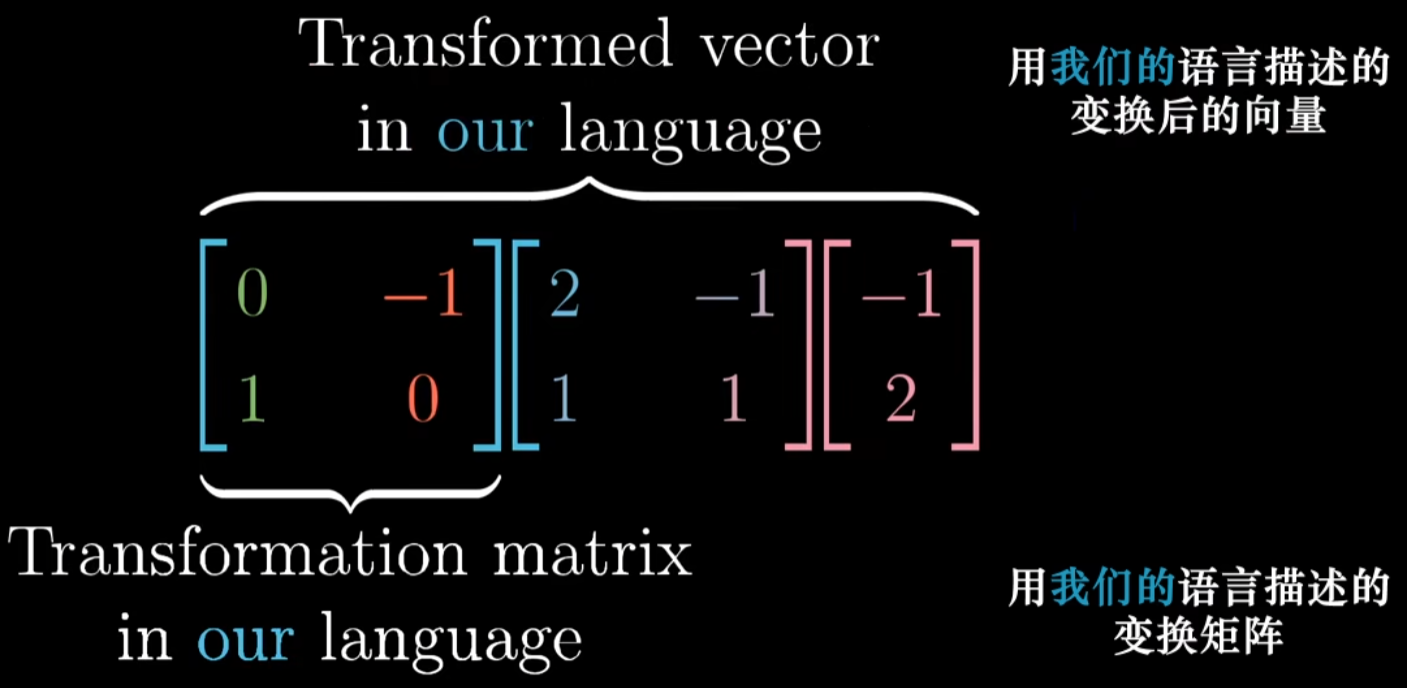

左侧乘以我们的语言描述的变换矩阵

然后左乘以基变换矩阵的逆,从而得到变换后的向量,用詹妮弗的语言描述的

可以对任意詹妮弗语言描述的向量做同样的事:先应用基变换矩阵,然后应用线性变换,然后应用基变换矩阵的逆

这三个矩阵的复合就是用詹妮弗语言描述的线性变换矩阵,它接收詹妮弗语言描述的向量,并输出用詹妮弗语言描述的变换后的向量,在这一例子中,詹妮弗的基向量用我们的语言描述就是(2,1)和(-1,1),线性变换是90度旋转

如果用这一矩阵和詹妮弗坐标系中的一个向量相乘,结果就是在他的坐标系中描述的该向量旋转90度的结果

如何在另一个坐标系中表达当前坐标系所描述的变换

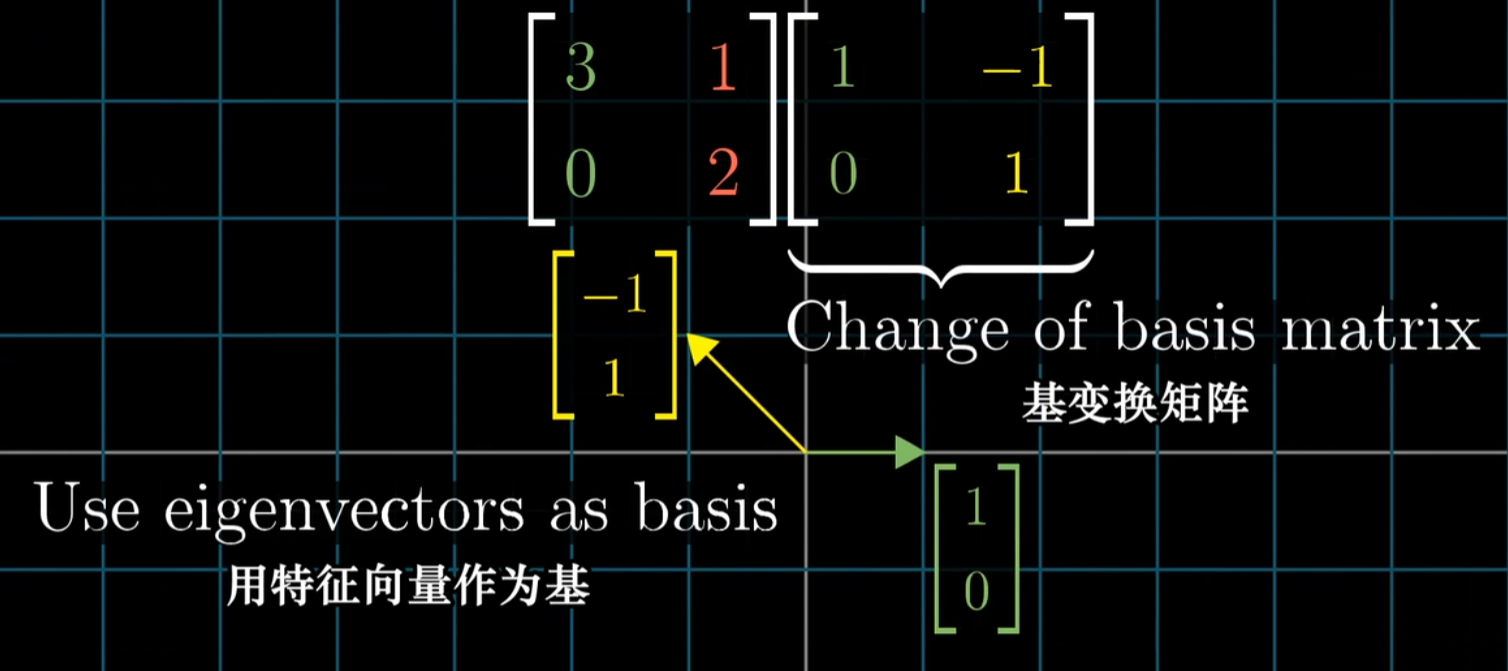

取出你想作为新基的向量的坐标(比如用特征向量作为基),然后将坐标作为一个矩阵的列,这个矩阵就是基变换矩阵

在当前坐标系表述的变换右侧写下基变换矩阵,左侧写下基变换矩阵的逆,把原始的变换夹在两个矩阵中间时,所得的矩阵代表的是同一个这一变换在新基向量所构成的坐标系的角度观察的结果

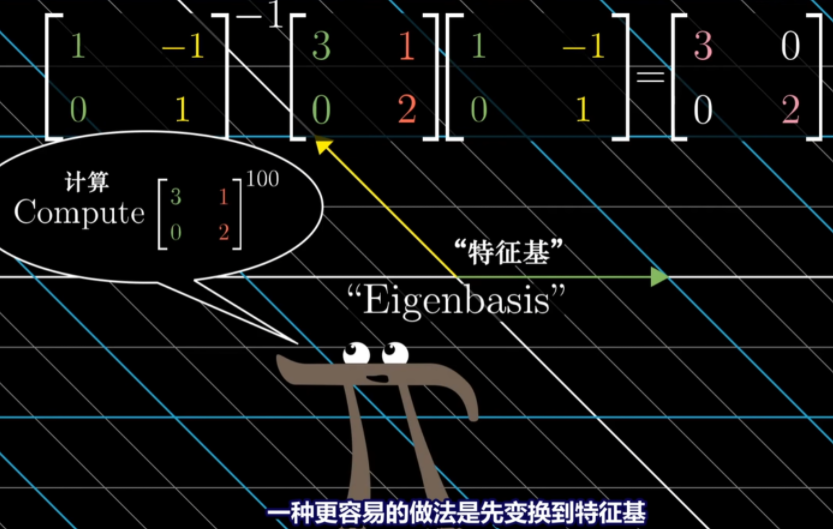

- 用特征向量来完成这件事的意义在于,这个新矩阵必然是对角的,并且对角元为对应的特征值,因为这一新矩阵所处的坐标系的基向量在变换中只进行了缩放

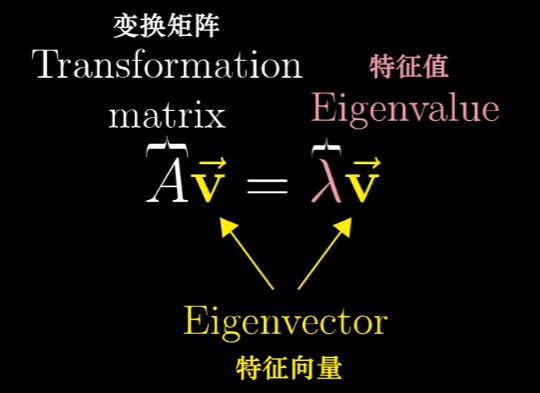

特征向量与特征值

对于某一变换,向量在变换后仍然留在它自己张成的空间里(向量所在的直线)的向量就是特征向量,每个特征向量都有一个对应的特征值,即衡量特征向量在变换中拉伸或压缩比例的因子

在三维的旋转中,如果能找到旋转这一变换的特征向量,其实找到的就是旋转的轴

在旋转中,特征向量对应的特征值必须为1,因为旋转并不缩放任何一个向量

- 下式可以理解成,向量v经过A变换后的结果与直接对向量v进行$\lambda$缩放的结果重合

求解特征向量和特征值,实际上就是求解使得这个等式成立的向量$\vec{v}$和$\lambda$

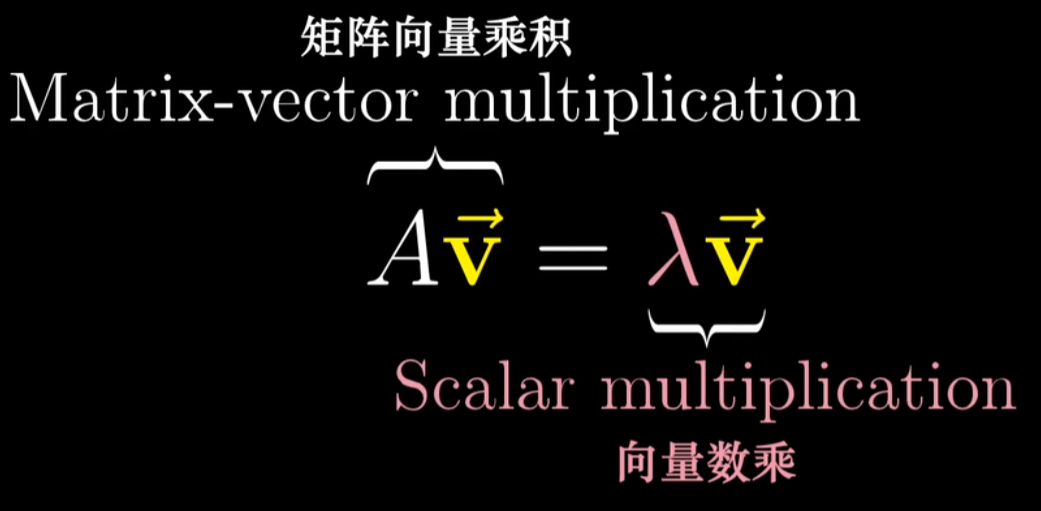

上式的等号左侧是矩阵向量乘积,而右侧是向量数乘,我们需要处理两种不同形式的乘法。

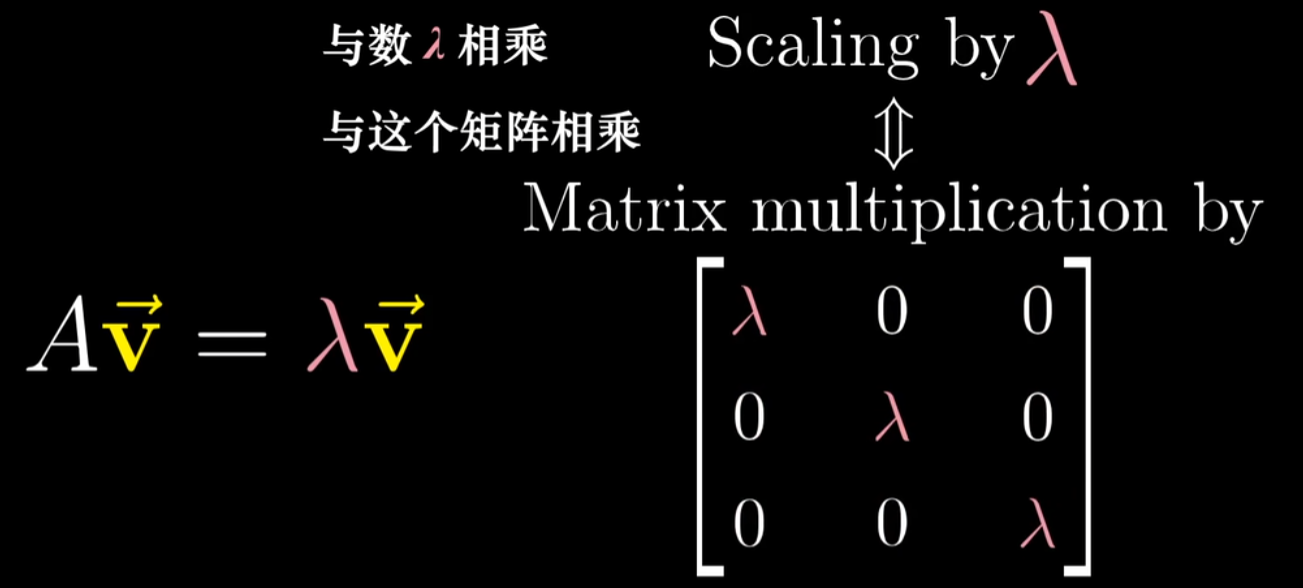

- 首先将等号右侧重写为某个矩阵向量乘积,其中矩阵的作用效果是将任一向量乘以$\lambda$,这个矩阵的列代表着变换后的基向量,而每个基向量仅仅与$\lambda$相乘,所以这一矩阵的对角元为$\lambda$,其余位置都是0

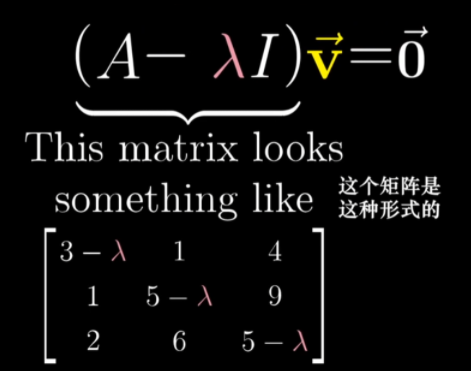

现在等式两边都是矩阵向量乘积的形式了,因此可以移项然后提出因子$\vec{v}$,得到如下形式:

寻找一个向量$\vec{v}$,使得这个新矩阵和$\vec{v}$相乘的结果为零向量

- $\vec{v}$如果为零向量,则等式恒等,但我们关注的是非零向量的情况

- 当且仅当矩阵代表的变换将空间压缩到更低的维度时,才会存在一个非零向量,使得矩阵和它的乘积为零向量,而==空间压缩对应的就是矩阵的行列式为零==,我们通过令$(A-\lambda I)$的行列式为零,求得特征值$\lambda$.

- $\vec{v}$是A 的一个特征向量,在变换中停留在它张成的空间里

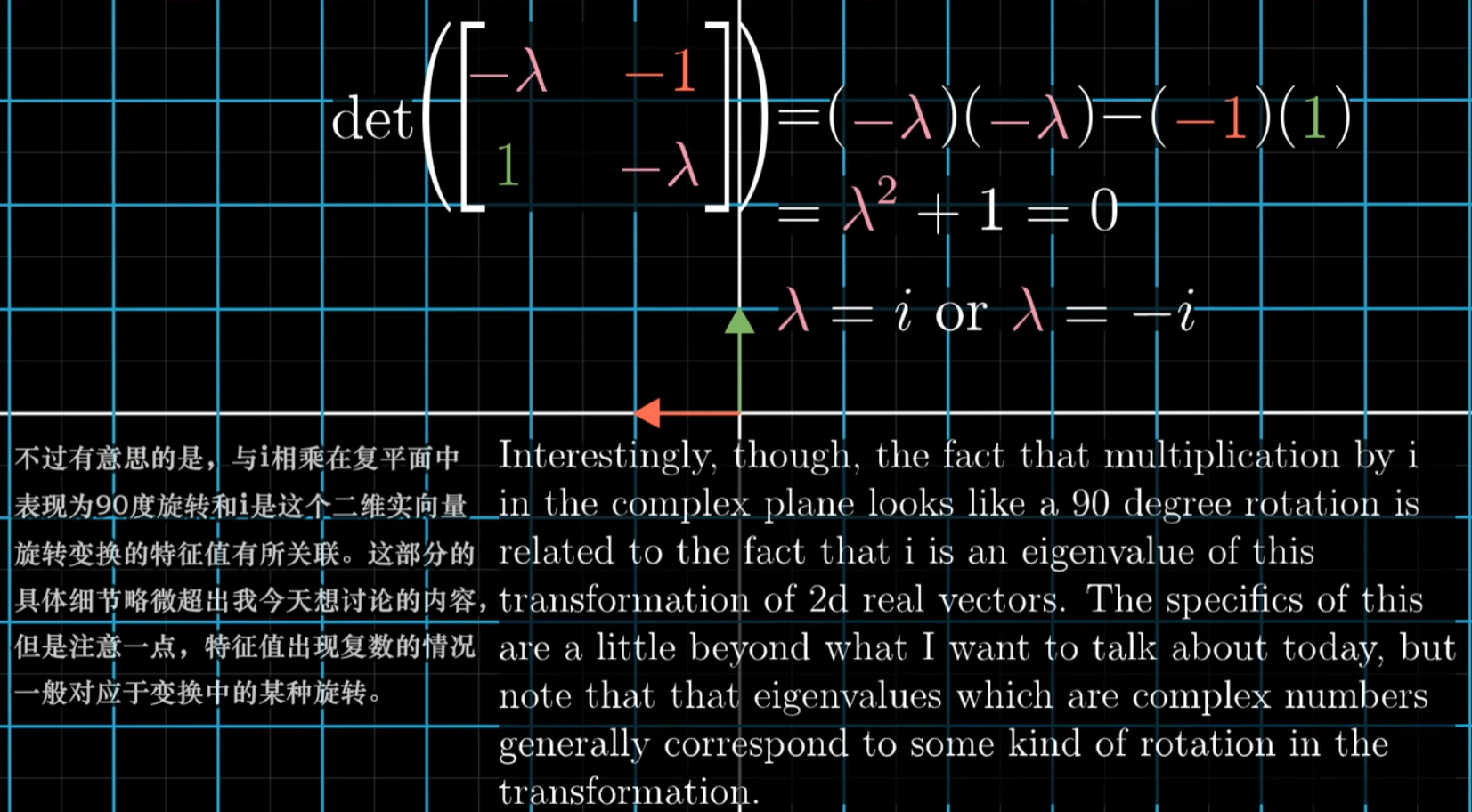

线性变换不一定有特征向量,比如旋转90度,所有的向量都离开了其原本张成的空间,求特征值会发现没有实数解,没有实数解代表这一变换没有特征向量

对角矩阵的性质:

- 对角矩阵所有的基向量都是特征向量

- 对角线上元素的值就对应每一列代表的基向量所属的特征值

- 对角矩阵的一个重要应用是计算矩阵与自己多次相乘的结果